Zbudowałem sprytne narzędzie AI do „humanizowania” tekstu, które ma sprawiać, że treści generowane przez sztuczną inteligencję brzmią bardziej naturalnie i autentycznie, ale mam problem z uzyskaniem szczerych opinii od prawdziwych użytkowników. Chciałbym wiedzieć, jak działa w rzeczywistym użyciu: czy faktycznie brzmi jak napisane przez człowieka, czy można mu ufać przy pisaniu treści i SEO oraz gdzie się nie sprawdza lub brzmi wyraźnie jak wytwór AI. Potrzebuję szczegółowych, praktycznych opinii, żebym mógł naprawić błędy, poprawić jakość i upewnić się, że jest bezpieczne oraz niezawodne dla blogerów, marketerów i zwykłych użytkowników, którzy chcą mieć treści AI brzmiące jak ludzkie.

Clever AI Humanizer: moje faktyczne doświadczenie, z dowodami

Ostatnio sporo bawiłem się różnymi „AI humanizerami”, głównie dlatego, że ciągle widziałem na Discordzie i Reddicie pytania, które z nich jeszcze działają. Wiele z nich albo się posypało, albo z dnia na dzień zamieniło się w płatny SaaS, albo po cichu zaczęło działać gorzej.

Więc postanowiłem zacząć od narzędzi naprawdę darmowych, bez logowania, bez karty. Pierwsze na liście: Clever AI Humanizer.

Możesz go znaleźć tutaj:

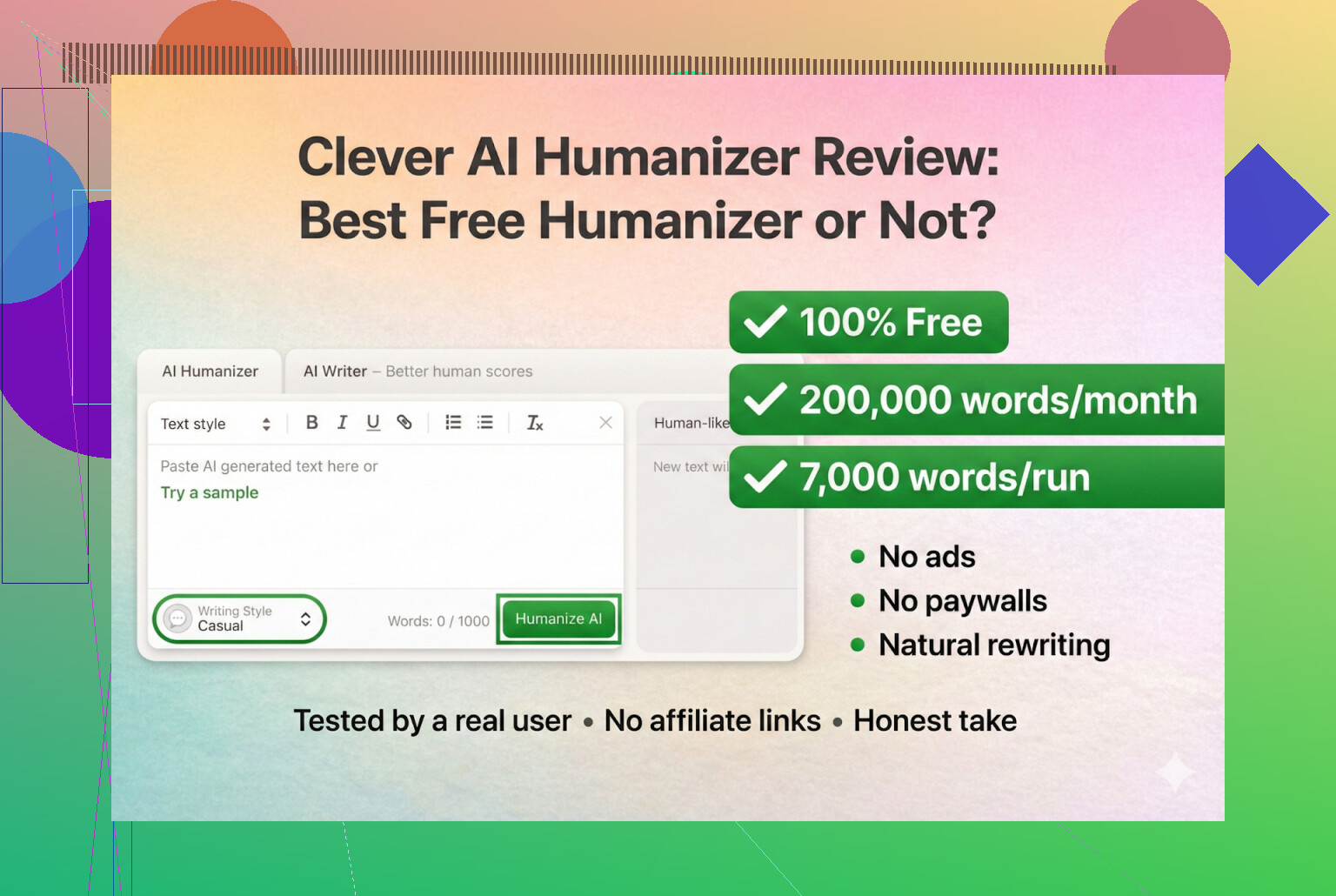

Clever AI Humanizer — Najlepszy w 100% darmowy humanizer

Z tego, co widzę, to jest ten prawdziwy, nie klon, nie dziwny rebrand.

Zamieszanie z URL-ami i fałszywe kopie

Małe ostrzeżenie, bo sam się raz naciąłem: w sieci jest mnóstwo stron „AI humanizer” z podobnymi nazwami, które kupują reklamy na te same słowa kluczowe. Kilka osób pisało do mnie prywatnie, pytając „która strona to ten prawdziwy Clever AI Humanizer?”, bo trafili na zupełnie inny serwis, który próbował im coś sprzedawać jako „pro” funkcje.

Dla jasności:

- Sam Clever AI Humanizer (Clever AI Humanizer — Najlepszy w 100% darmowy humanizer)

- Z tego, co widziałem:

- Brak planów premium

- Brak subskrypcji

- Brak wyskakujących okienek typu „odblokuj kolejne 5000 słów za 9,99 $”

Jeśli kliknąłeś reklamę z Google i nagle Twoja karta zaczęła być obciążana, to nie było to narzędzie.

Jak to testowałem (w pełni AI na AI)

Chciałem zobaczyć, jak daleko to narzędzie dojdzie w najgorszym scenariuszu, więc w ogóle go nie oszczędzałem.

- Poprosiłem ChatGPT 5.2, żeby napisał całkowicie AI‑owy artykuł o Clever AI Humanizer.

- Zero ludzkich poprawek.

- Prosty kopiuj‑wklej.

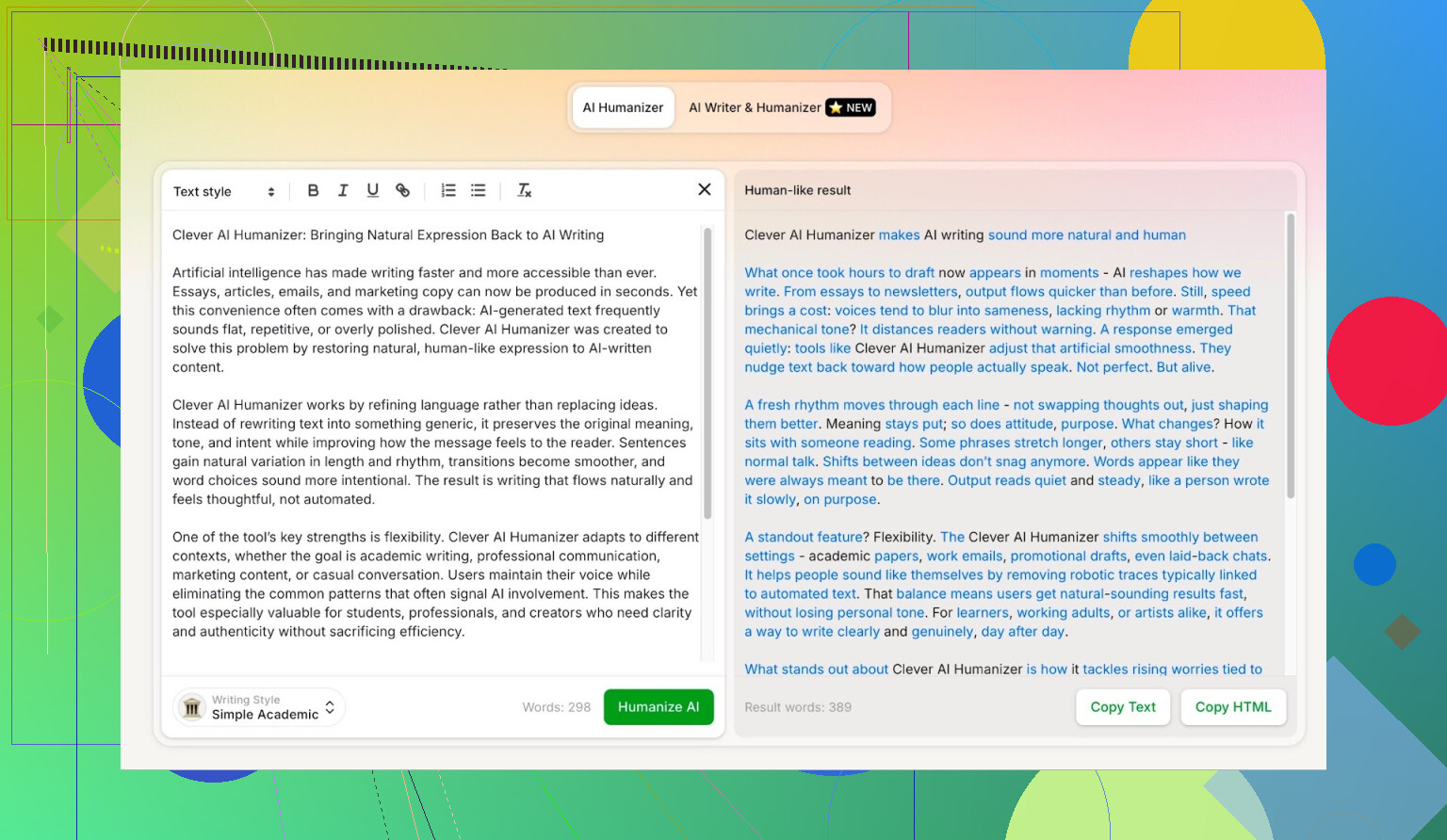

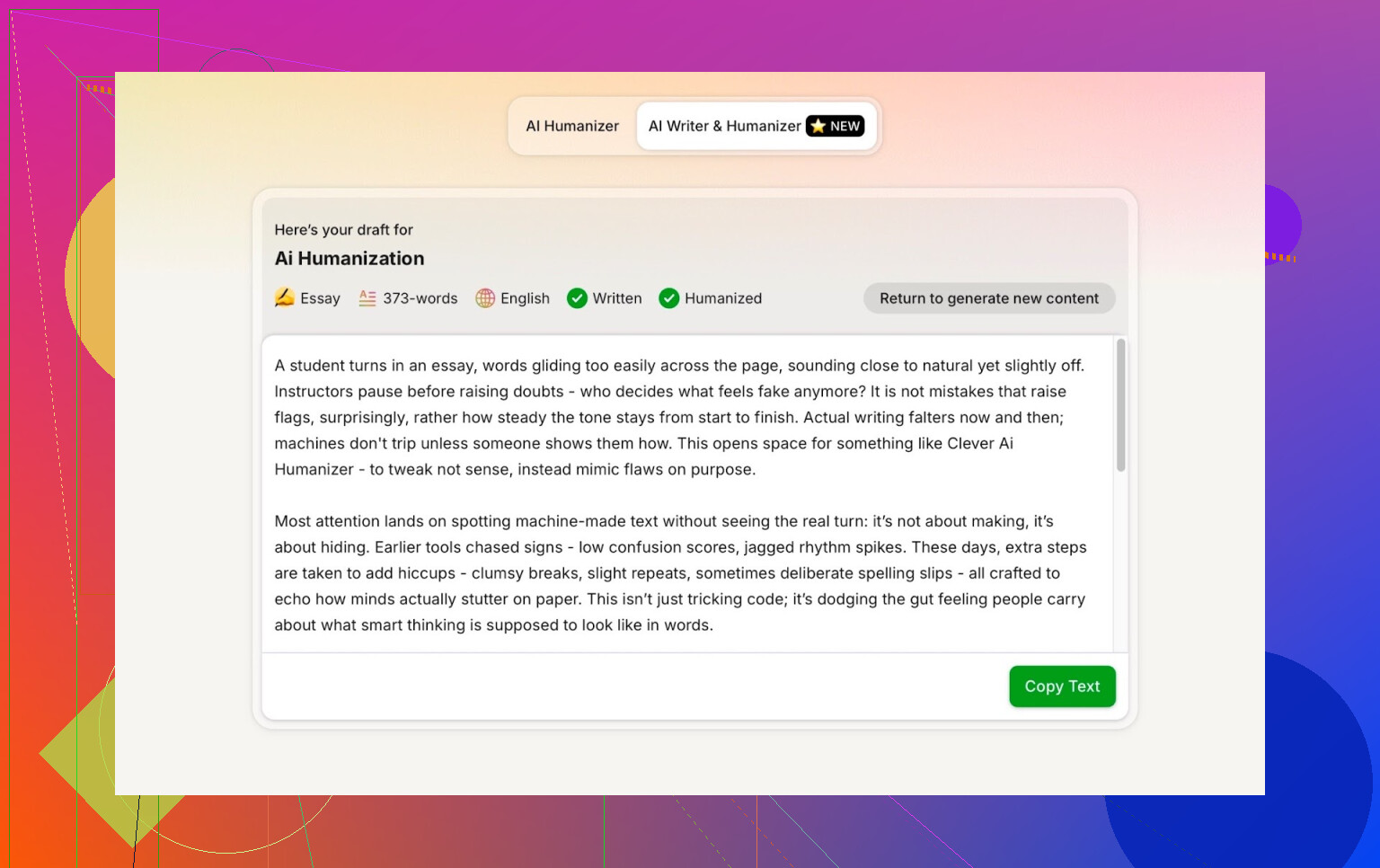

- Wrzuciłem ten tekst do Clever AI Humanizer w trybie Simple Academic.

- Przepuściłem wynik przez kilka detektorów AI.

- Potem poprosiłem ChatGPT 5.2, żeby sam ocenił przepisany tekst.

Dzięki temu nie ma wymówki typu „może wyjściowy tekst i tak był bardzo ludzki”. To w 100% maszyna do maszyny.

Tryb Simple Academic: dlaczego wybrałem najtrudniejszą opcję

Nie wybierałem trybu Casual, Blog ani nic „miękkiego”. Od razu wskoczyłem w Simple Academic.

Jak ten tryb wypada w praktyce:

- Ciągle czytelny, bez bełkotu w stylu czasopism naukowych

- Lekko formalny, uporządkowany, schludny

- Wystarczająco „akademicko” brzmiący, żeby wyglądał poważnie, ale nie jak praca dyplomowa

Ta środkowa półka to dokładnie miejsce, gdzie detektory AI zwykle zaczynają krzyczeć „AI!”, bo zdania stają się zbyt równe i poukładane. Więc jeśli humanizer potrafi utrzymać ten styl i nadal wypada dobrze w testach, to jest ciekawie.

ZeroGPT: „Nie ufam, ale wszyscy używają”

Nie jestem fanem ZeroGPT z jednego głównego powodu: oznacza Konstytucję USA jako „100% AI”.

Jak raz to zobaczysz, zaufanie spada do zera.

Mimo to:

- Narzędzie wciąż dominuje w Google.

- Ludzie nadal z niego korzystają, bo jest w pierwszych wynikach.

- Więc je uwzględniłem.

Wynik dla tekstu z Clever AI Humanizer:

ZeroGPT: 0% AI wykryte.

Jak na to narzędzie, lepiej już praktycznie być nie może.

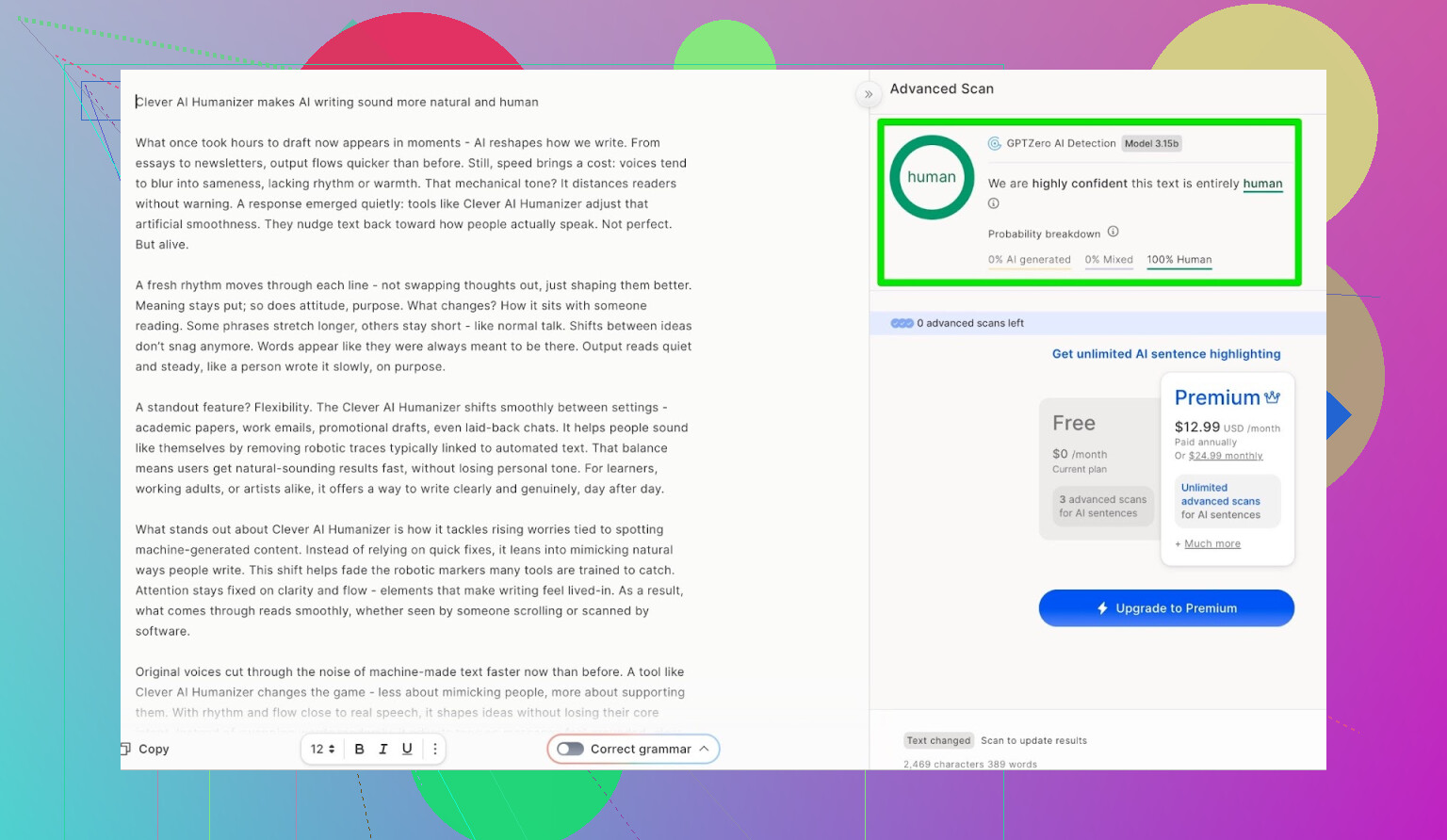

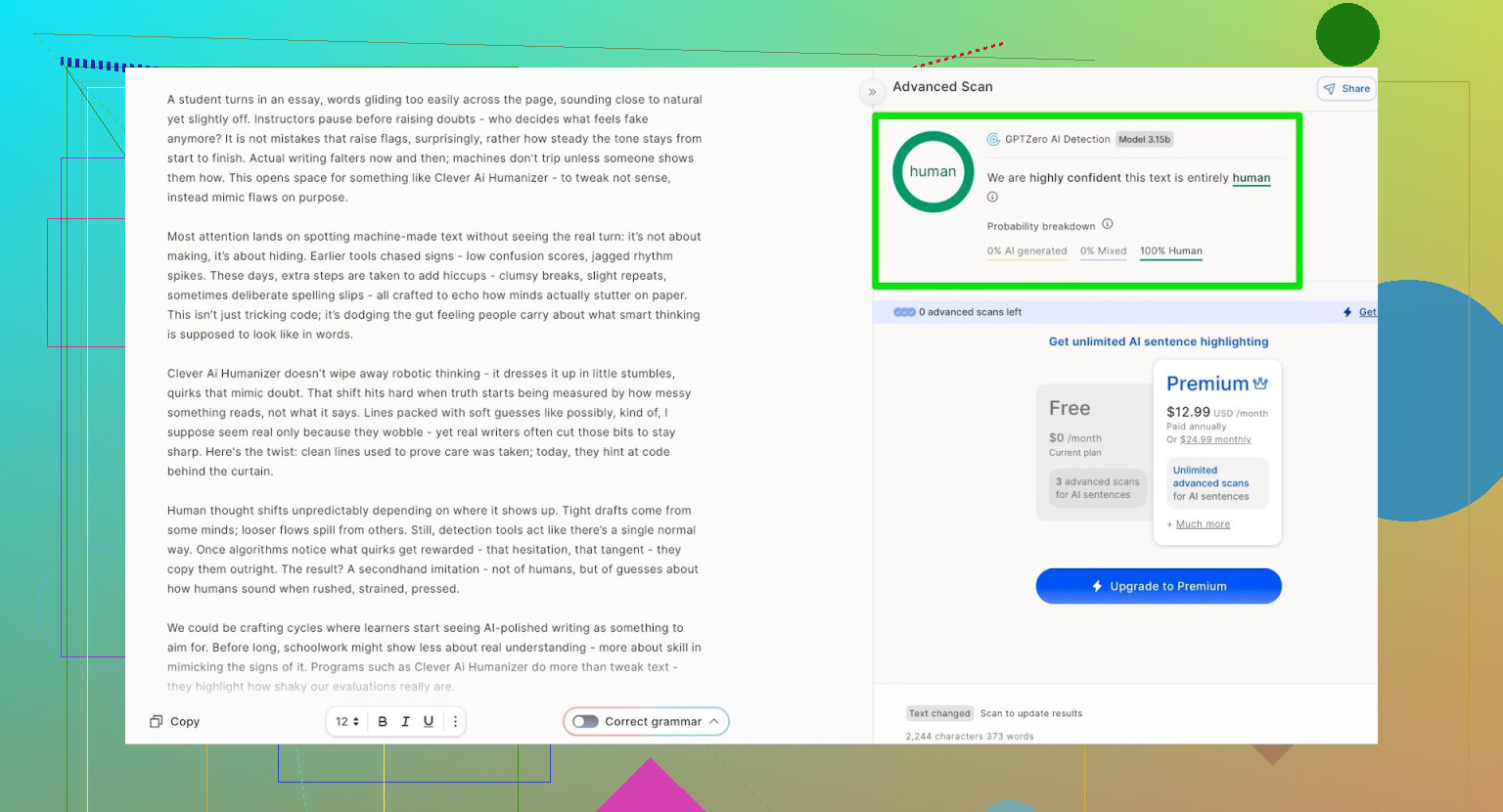

GPTZero: druga opinia, ta sama historia

Kolejny był GPTZero.

To narzędzie jest szeroko używane w szkołach i na uczelniach, więc często budzi największy strach.

Wynik tekstu z Clever AI Humanizer (tryb Simple Academic):

- 100% tekstu ludzkiego

- 0% AI

Czyli w dwóch najpopularniejszych publicznych detektorach tekst przeszedł z idealnymi wynikami.

Ale czy to czyta się jak śmieć?

Tu wiele humanizerów się wykłada:

Przechodzą detektory, ale tekst brzmi, jakby ktoś puścił wypracowanie przez 4 translatory i z powrotem.

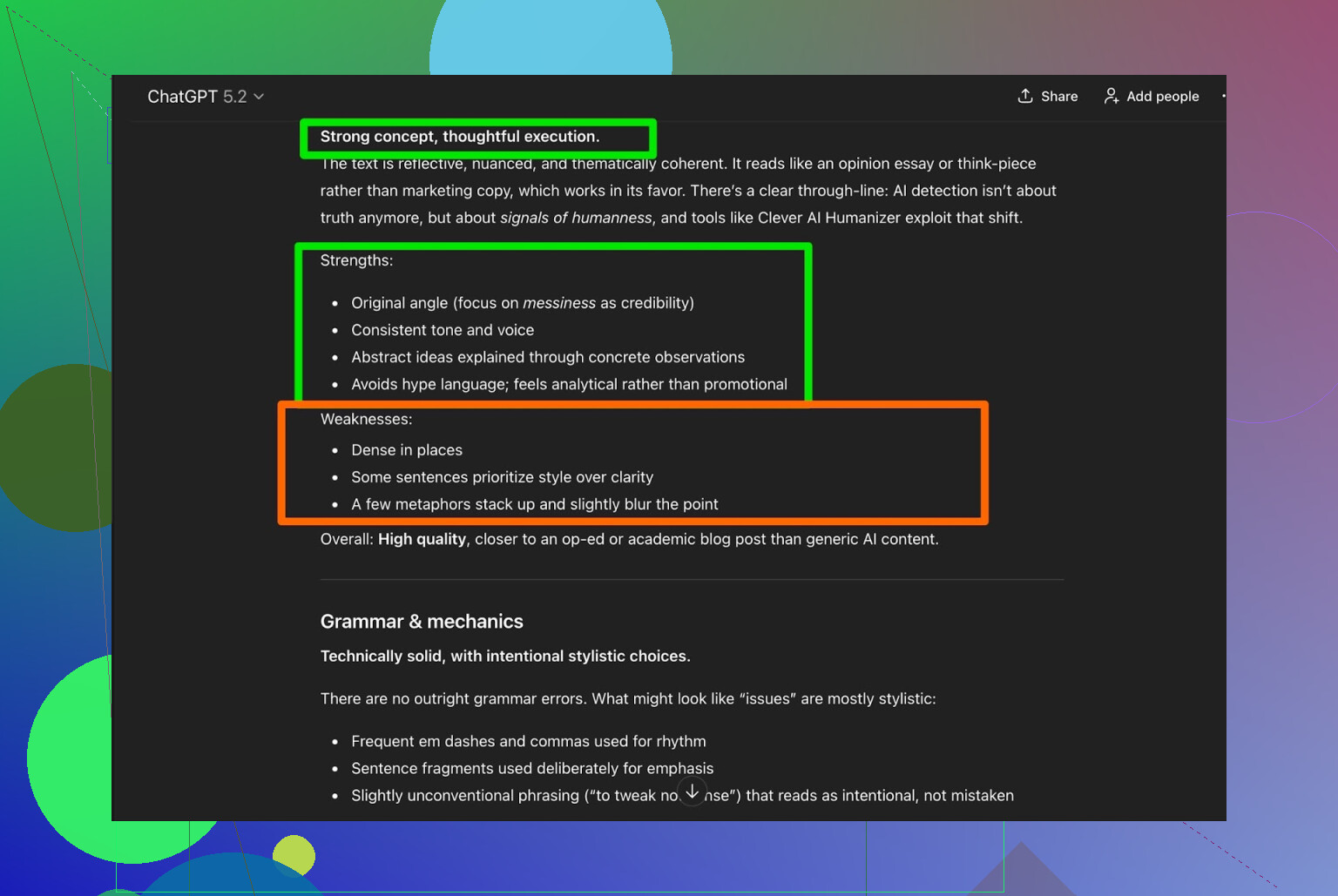

Wziąłem wynik z Clever AI Humanizer i poprosiłem ChatGPT 5.2, żeby go przeanalizował:

Ogólny werdykt:

- Gramatyka: solidna

- Styl: całkiem dobrze trafia w Simple Academic

- Rekomendacja: nadal sugeruje, że ludzka redakcja jest wskazana

Szczerze mówiąc, zgadzam się. Taka jest rzeczywistość:

Każdy tekst napisany lub „uhumanizowany” przez AI nadal zyskuje na tym, że człowiek go przeczyta.

Jeśli jakieś narzędzie obiecuje „zero potrzeby edycji przez człowieka”, to najpewniej marketing, nie prawda.

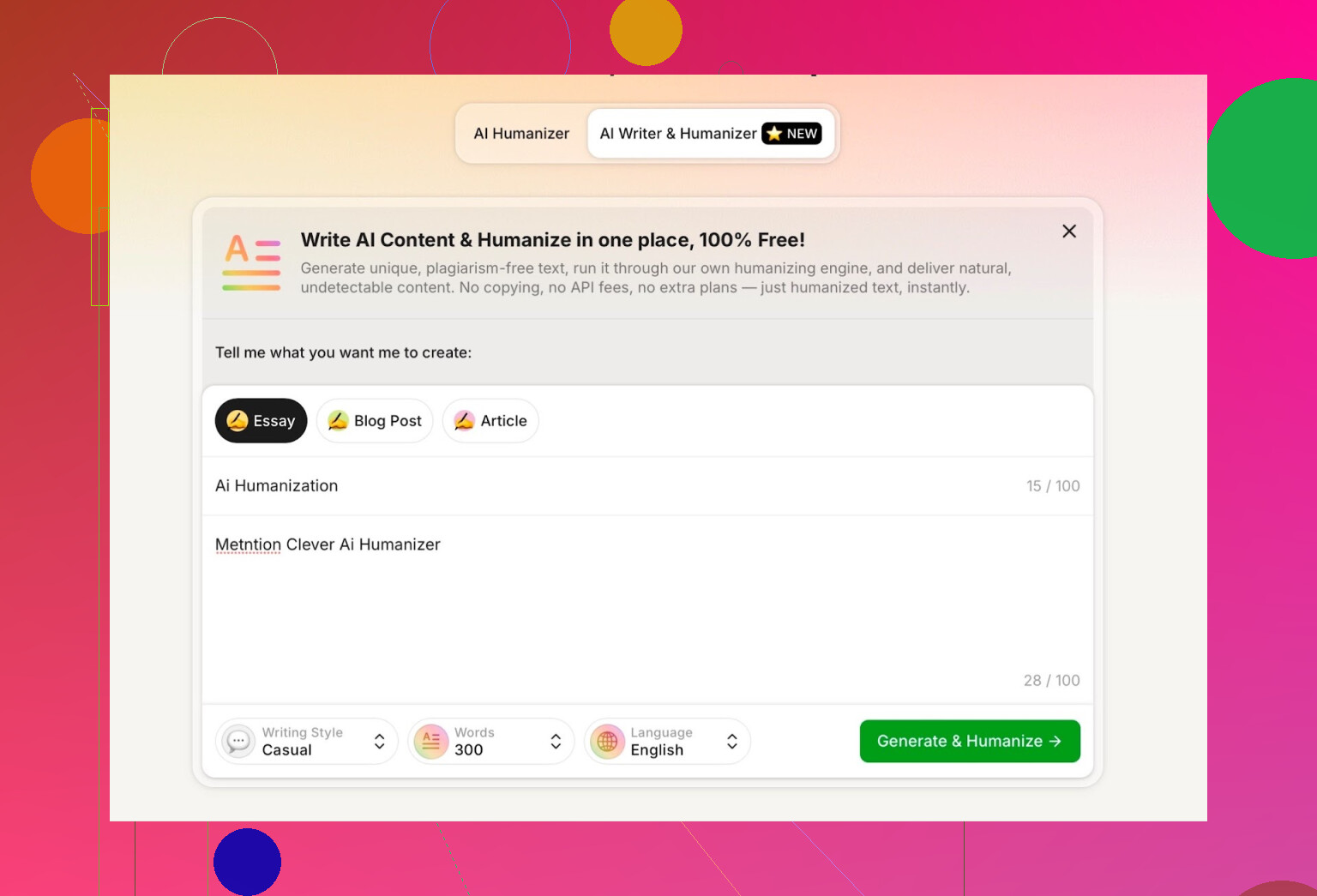

Testowanie wbudowanego AI Writer w Clever AI Humanizer

Mają osobne narzędzie tutaj:

https://aihumanizer.net/plai-writer

Tu robi się ciekawiej. Zamiast:

LLM → Kopiuj → Wklej do humanizera → Nadzieja na sukces

Możesz:

- Generować i humanizować w jednym kroku

- Pozwolić systemowi od początku kontrolować strukturę i styl

To ważne, bo jeśli narzędzie samo generuje treść, może ją ułożyć tak, by naturalnie unikała oczywistych wzorców AI.

Do testu:

- Wybrałem styl Casual

- Temat: humanizacja AI, z uwzględnieniem Clever AI Humanizer

- Celowo dodałem mały błąd w promptcie, żeby zobaczyć, jak sobie poradzi

Wynik był czysty, konwersacyjny i nie powtórzył mojego literowego błędu w dziwny sposób.

Jedna rzecz, która mi się nie spodobała:

- Poprosiłem o 300 słów

- Dostałem więcej niż 300

Jeśli mówię 300, chcę 300. Nie 412. Takie rzeczy mają znaczenie, jeśli masz sztywne limity prac czy dokładne wytyczne w briefie.

To mój pierwszy realny zarzut.

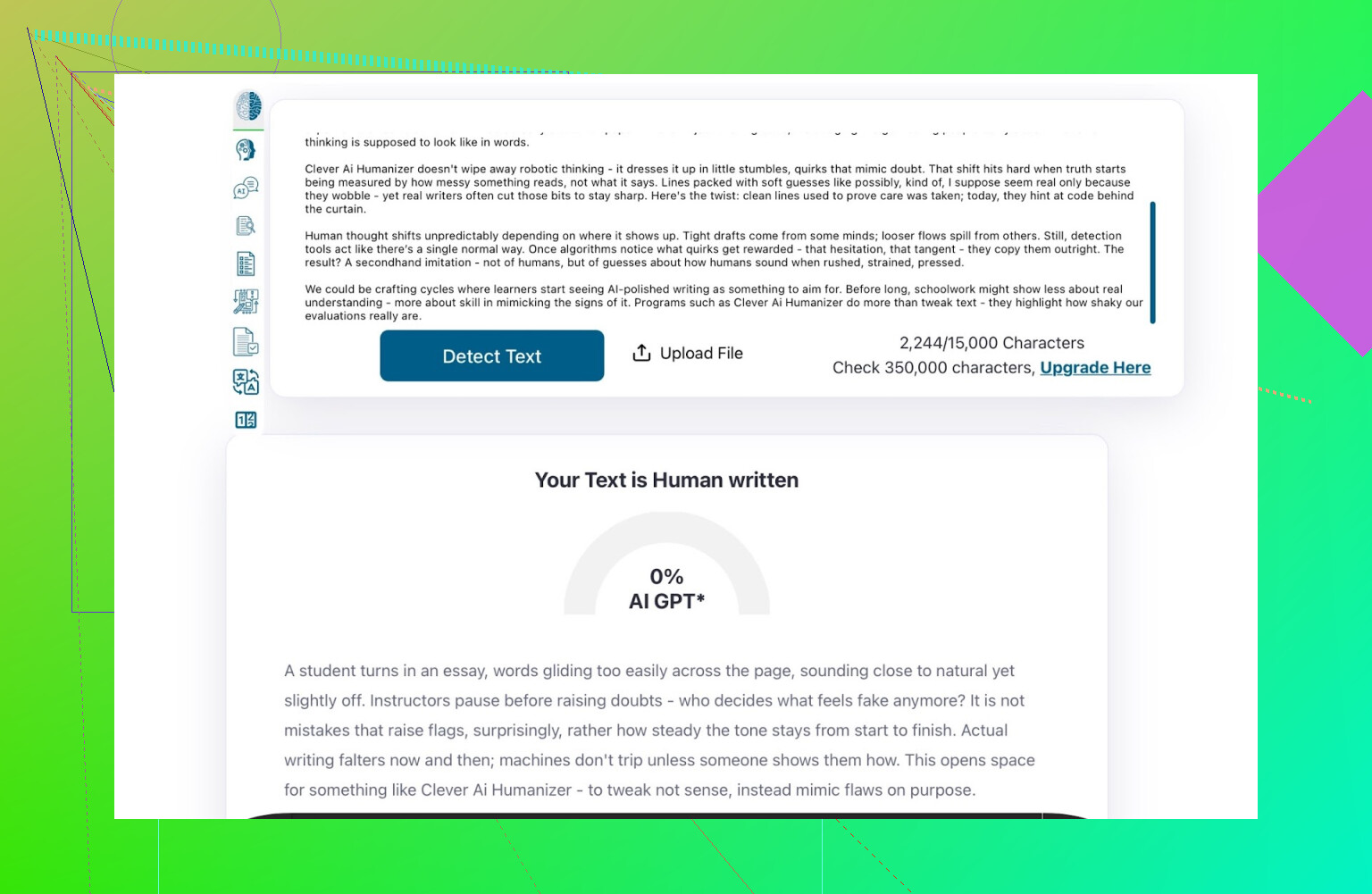

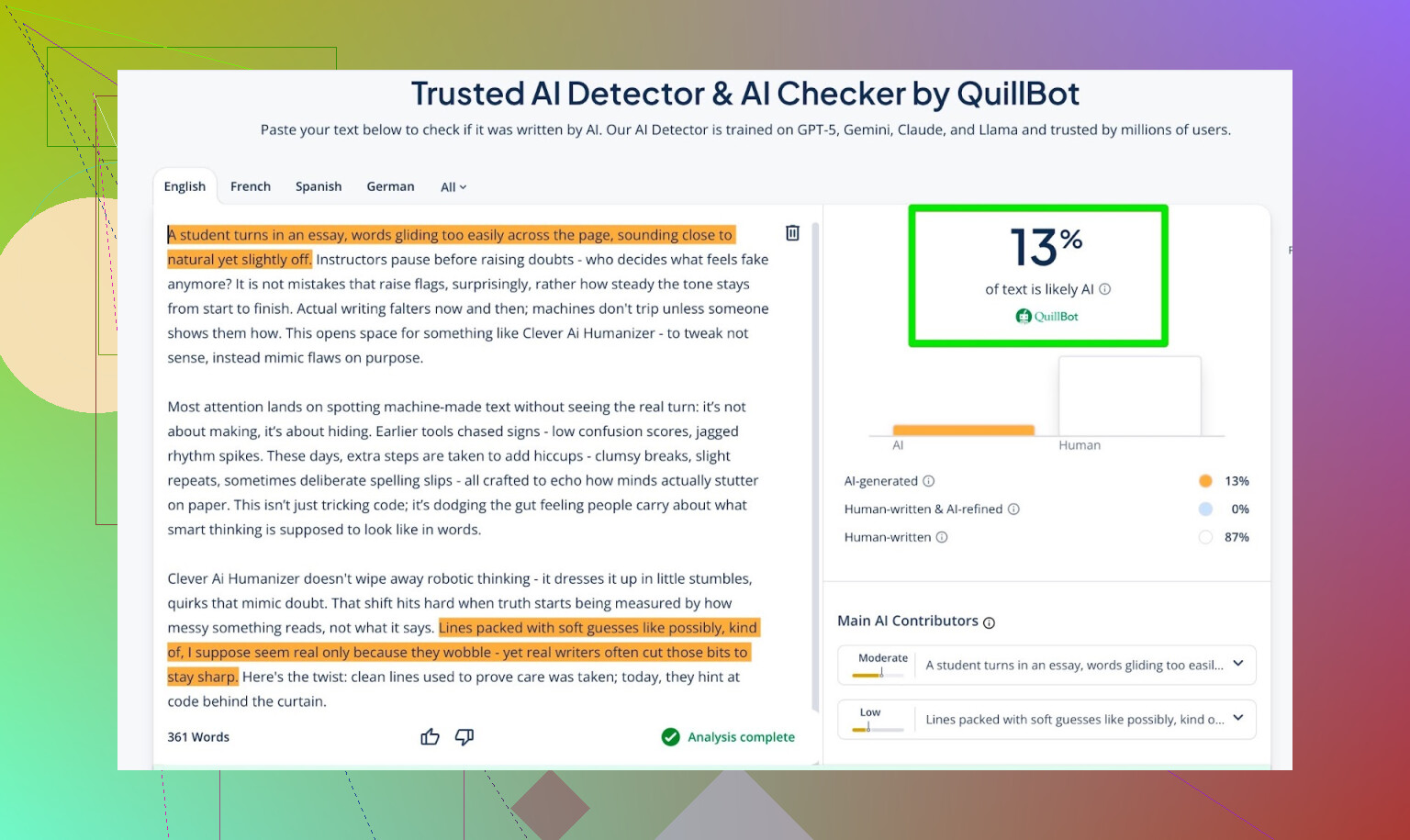

Wyniki detekcji dla tekstu z AI Writer

Tekst wygenerowany przez AI Writer przepuściłem przez:

- GPTZero

- ZeroGPT

- Detektor QuillBot jako dodatkowy punkt odniesienia

Wyniki:

- GPTZero: 0% AI

- ZeroGPT: 0% AI, 100% human

- QuillBot: 13% AI

Czyli QuillBot zauważył lekki „AI‑owy” wzorzec, ale nadal głównie tekst ludzki.

Ogólnie – całkiem nieźle.

Prośba do ChatGPT 5.2 o ocenę tekstu z AI Writer

Najbardziej zależało mi nie tylko na tym, czy „oszuka detektory”, ale też:

- Czy brzmi jak człowiek?

- Czy zachowuje spójność?

- Czy czyta się naturalnie?

Przekleiłem tekst z AI Writer do ChatGPT 5.2 i zapytałem, czy wygląda na napisany przez człowieka, czy przez AI.

Wnioski ChatGPT 5.2:

- Brzmi jak tekst ludzki

- Jakość wysoka

- Nic rażącego w gramatyce ani strukturze

Czyli w tym momencie tekst:

- Ładnie przeszedł przez trzy publiczne detektory AI

- „Oszukał” też nowoczesny model językowy, który uznał go za ludzki

Jak wypada na tle innych humanizerów, które sprawdziłem

W moich testach Clever AI Humanizer poradził sobie lepiej niż sporo innych narzędzi, o których ludzie często wspominają.

Poniżej szybkie podsumowanie z tych prób:

| Narzędzie | Darmowe | Wynik w detektorze AI |

| ⭐ Clever AI Humanizer | Tak | 6% |

| Grammarly AI Humanizer | Tak | 88% |

| UnAIMyText | Tak | 84% |

| Ahrefs AI Humanizer | Tak | 90% |

| Humanizer AI Pro | Ograniczone | 79% |

| Walter Writes AI | Nie | 18% |

| StealthGPT | Nie | 14% |

| Undetectable AI | Nie | 11% |

| WriteHuman AI | Nie | 16% |

| BypassGPT | Ograniczone | 22% |

Narzędzia, które w moich realnych testach przebił:

- Grammarly AI Humanizer

- UnAIMyText

- Ahrefs AI Humanizer

- Humanizer AI Pro

- Walter Writes AI

- StealthGPT

- Undetectable AI

- WriteHuman AI

- BypassGPT

Dla jasności: ta tabela opiera się na wynikach z detektorów, nie na tym, „który tekst brzmi najładniej subiektywnie”.

Gdzie Clever AI Humanizer wciąż ma braki

To nie jest magia i nie jest bezbłędne.

Kilka problemów, które zauważyłem:

- Słaba kontrola liczby słów

- Poprosisz o 300 słów, dostaniesz 280 albo 370.

- Wzorce nadal mogą się pojawiać

- Niektóre modele wciąż potrafią oznaczyć fragmenty jako AI‑owe.

- Dryf treści

- Tekst nie zawsze wiernie trzyma się oryginału; czasem przerabia go mocniej, niż byś chciał.

Na plus:

- Jakość gramatyczna: w moich testach jakieś 8–9/10

- Płynie na tyle dobrze, że nie potykasz się o co drugie zdanie

- Brak irytującej strategii „celowych literówek” typu „i was” zamiast „I was”, żeby tylko zbić detektory

To ostatnie ma znaczenie. Niektóre narzędzia celowo psują tekst, żeby wydał się bardziej ludzki. Może to zwiększa szanse na przejście detektorów, ale obniża jakość treści.

Dziwna rzecz: 0% AI nie zawsze „czuje się” jak człowiek

Jest coś subtelnego, co trudno opisać: nawet gdy kilka detektorów pokazuje 0% AI, czasem nadal czujesz, że tekst jest ułożony przez maszynę. Rytm, sposób wprowadzania myśli, zbytnia gładkość.

Clever AI Humanizer radzi sobie z tym lepiej niż większość, ale ten bazowy wzorzec nadal bywa wyczuwalny. To nie tyle wada narzędzia, co po prostu stan całego ekosystemu.

To trochę zabawa w kotka i myszkę:

- Detektory się doskonalą

- Humanizery się dostosowują

- Detektory znów się aktualizują

- I tak w kółko

Jeśli oczekujesz, że jakieś narzędzie będzie „odporne na przyszłość”, rozczarujesz się.

Czy to „najlepszy” darmowy humanizer na ten moment?

Spośród darmowych narzędzi, które faktycznie przetestowałem detektorami i modelami LLM:

- Postawiłbym Clever AI Humanizer jak dotąd na pierwszym miejscu.

- Zwłaszcza biorąc pod uwagę, że ma zarówno:

- Humanizer do gotowego tekstu

- Zintegrowany AI Writer, który humanizuje w trakcie pisania

Nadal musisz:

- Sam przeczytać wynik

- Poprawić to, co zgrzyta

- Dopasować ton, żeby brzmiał jak Ty

Ale jeśli Twoje pytanie brzmi:

„Czy Clever AI Humanizer jest teraz wart wypróbowania, zwłaszcza że jest darmowy?”

To na podstawie moich testów: tak.

Dodatkowe materiały, jeśli chcesz głębiej w to wejść

W sieci krąży kilka dyskusji i testów na Reddicie z dodatkowymi screenami i dowodami:

-

Ogólne porównanie najlepszych AI humanizerów z wynikami detekcji:

https://www.reddit.com/r/DataRecoveryHelp/comments/1oqwdib/best_ai_humanizer/?tl=pl -

Konkretny wątek recenzujący Clever AI Humanizer:

https://www.reddit.com/r/DataRecoveryHelp/comments/1ptugsf/clever_ai_humanizer_review/?tl=pl

Jeśli zdecydujesz się korzystać z Clever AI Humanizer, traktuj go raczej jako:

- Pomocnika, nie zastępstwo

- Coś, co dowozi 70–90% pracy

- Narzędzie, którego wartość zależy od tego, jak dobrze człowiek ogarnie finalny tekst

Na końcu i tak Ty odpowiadasz za te słowa.

Krótko: nie uzyskasz takiego „szczerego feedbacku od prawdziwych użytkowników”, jakiego chcesz, tylko patrząc na wyniki detektorów czy pytając inne AI, co o tym myślą. To jest część historii, ale też najbardziej leniwa część.

Widziałeś już, jak @mikeappsreviewer robił „olimpiadę detektorów” i testy strukturalne. To jest przydatne, ale wciąż nie mówi ci, jak twoje narzędzie się „czuje”, gdy ktoś jest zmęczony o 1 w nocy i próbuje dokończyć pracę, albo gdy content manager hurtowo obrabia 20 artykułów i jest na skraju rezygnacji.

Jeśli chcesz sygnału z realnego świata, rób rzeczy takie jak te:

-

Osadź feedback w momencie użycia

- Po każdym uruchomieniu: 3‑klikowa mikroankieta:

- „Brzmiało: [Zbyt robotycznie] [Dość naturalnie] [Bardzo po ludzku]”

- „Czy ten wynik jest bezpieczny do wysłania bez zmian? [Tak/Nie]”

- Potem małe, opcjonalne pole tekstowe: „Co cię wkurzyło?”

- Nie pytaj „Co ci się podobało?”. Tak dostajesz fałszywe pochwały. Pytaj, co było złe.

- Po każdym uruchomieniu: 3‑klikowa mikroankieta:

-

Śledź zachowania, a nie tylko opinie

- Mierz:

- Jak często użytkownicy klikają „generuj ponownie”

- Jak często od razu edytują tekst w twoim edytorze (jeśli go masz)

- Rezygnacje w trakcie sesji

- Jeśli ludzie generują ponownie 3–4 razy na jedno wejście, narzędzie samo ci mówi, że zawodzi, nawet jeśli ankiety wyglądają dobrze.

- Mierz:

-

Rób ukierunkowane testy z prawdziwymi użytkownikami zamiast losowego ruchu

Zbierz małe, konkretne grupy zamiast „całego internetu”:- Studentów, którzy próbują uniknąć flag AI

- Freelancerów/agencje contentowe

- Osoby nie‑native, które szlifują angielski

Zaproponuj im: - Prywatną przestrzeń testową

- Kilka stałych zadań (przepisz wstęp eseju, wypoleruj post na LinkedIn itd.)

- 10–15‑minutową rozmowę lub nagraną sesję ekranową dla każdego

Przekup ich kartami podarunkowymi Amazona, darmowym premium, czymkolwiek. Jakościowy feedback od 20 takich osób przebije 2 000 anonimowych kliknięć.

-

Rób A/B testy swojego narzędzia względem punktu odniesienia

Zamiast pytać „Czy to jest dobre?”, pytaj „Czy to jest lepsze niż X?”

Możesz po cichu puścić:- Wersja A: surowe wyjście LLM

- Wersja B: twoje „uhumanizowane” wyjście

Pokazuj je testerom w ciemno i pytaj: - „Które brzmi bardziej jak napisane przez prawdziwego człowieka?”

- „Które faktycznie byś wysłał/opublikował?”

Nie musisz nawet wspominać o detektorach.

-

Celowo korzystaj z „wrogich” recenzentów

Znajdź ludzi, którzy nie znoszą treści AI albo są ultra‑wymagającymi redaktorami.

Powiedz im:- „Wyobraź sobie, że to przyniósł ci junior copywriter. Roznieś to na strzępy.”

Ich uwagi o tonie, powtórzeniach, sztywności i logice są dużo cenniejsze niż „ZeroGPT pokazuje 0% AI”.

- „Wyobraź sobie, że to przyniósł ci junior copywriter. Roznieś to na strzępy.”

-

Używaj narzędzia na sobie publicznie, ale uczciwie

Używaj wyjść Clever AI Humanizer w:- Tekstach na stronie produktu

- Informacjach o wydaniach

- Postach na blogu

Potem dodaj małą linijkę na dole:

„Ten wpis został przygotowany z pomocą Clever AI Humanizer i lekko zredagowany przez człowieka. Czy coś brzmiało dziwnie? Daj nam znać.”

Dostaniesz brutalny, surowy feedback od ludzi, którym na tyle zależy, że chce im się poskarżyć. -

Testuj „tryby porażki”, nie tylko „idealne przypadki”

Większość narzędzi wygląda dobrze na czystym, formalnym tekście. Ty powinieneś testować:- Chaotyczne prompt’y

- Łamany angielski

- Slang, emotikony, dziwne formatowanie

- Superkrótkie rzeczy, jak tematy maili

Pytaj użytkowników: - „Gdzie kompletnie nie trafiło?”

Zbieraj i kategoryzuj te porażki.

-

Uważaj na „problem vibów”

Nawet gdy detektory pokazują 0% AI, wiele tekstów wciąż „czuć maszyną”: ten sam rytm, równe akapity, przewidywalne przejścia.

Detektory tego nie złapią.

Złapiesz to, jeśli:- Zapytasz użytkowników: „Czy to brzmi jak ty?”

- Pozwolisz im wkleić „przed” i „po”, a potem zapytasz, którą wersję naprawdę wysłaliby do szefa albo promotora.

-

Nie fiksuj się za bardzo na omijaniu detektorów

Tu lekka niezgoda z podejściem skupionym na detektorach od @mikeappsreviewer: użytkownicy myślą, że chcą „0% AI”, ale na dłuższą metę trzyma ich to, że:- Tekst pasuje do ich tonu

- Nie wprowadza kłamstw

- Nie sprawia, że brzmią jak dziwny, generyczny bloger

Najpierw UX, potem „niewykrywalność”. Inaczej przykuwasz się do zabawy w kotka i myszkę, którą w końcu przegrasz.

-

Dodaj dla siebie brutalnie szczery „miernik jakości”

Wewnątrz, taguj każde uruchomienie (zanonimizowane) za pomocą:

- Wyników detektorów

- Oceny ludzkiej (od małego, zaufanego panelu)

- Feedbacku użytkownika („notatki wkurzenia”)

Co miesiąc przeglądaj swoje najgorsze 5–10% wyników. Tam jest złoto.

Jeśli chcesz konkretny następny krok:

- Postaw małą stronę „beta testerów” dla Clever AI Humanizer.

- Ogranicz ją do, powiedzmy, 50 prawdziwych użytkowników.

- Daj im jasną umowę: „Korzystasz za darmo, ale musisz wysłać 3 przykłady tygodniowo, gdzie narzędzie zawaliło albo brzmiało dziwnie.”

Nie brakuje ci tak naprawdę użytkowników. Brakuje ci ustrukturyzowanego, bolesnego feedbacku. Zbuduj do tego kanały, a w dwa tygodnie nauczysz się więcej niż z kolejnych 20 screenów z paneli detektorów.

Krótka odpowiedź: zrzuty ekranu z detektorów + samooceny AI to nie jest „prawdziwy feedback od użytkowników”, tylko eksperyment laboratoryjny. Jesteś w połowie drogi, ale pytasz nie tę publiczność.

Kilka myśli, które nie są tylko powtórką tego, co już opisali @mikeappsreviewer i @kakeru:

-

Przestań pytać, czy to „działa”, zacznij pytać, dla kogo działa

Teraz trochę gonisz za uniwersalną odpowiedzią: „Czy mój humanizer AI jest dobry?” To zbyt ogólne. W praktyce przypadki użycia są bardzo różne:

- Studenci próbujący nie zostać oznaczeni jako AI

- Copywriterzy chcący, by szkice brzmiały mniej robotycznie

- Osoby niebędące native speakerami, chcące brzmieć naturalniej w mailach

- Marketerzy chcący zachować głos marki

Twój problem z feedbackiem może być taki: wpuszczasz wszystkich i nie słuchasz żadnej konkretnej grupy. Wybierz jedną–dwie grupy i wokół nich zbuduj pętle informacji zwrotnych.

-

Zaproponuj zdecydowane presety i oceniaj po tym, który jest nadużywany

Zamiast ogólnych trybów typu „prosty akademicki” czy „luźny”, oprzyj je na realnych sytuacjach:

- „Szlif wypracowania na studia”

- „Post na LinkedIn z ekspercką opinią”

- „Cold mail do menedżera”

- „Poprawka wstępu do wpisu na bloga”

Następnie:

- Śledź, który preset jest używany najczęściej

- Śledź, przy którym najczęściej klikają „kopiuj wszystko” bez edycji

- Śledź, który użytkownicy porzucają w trakcie

Jeśli „Szlif wypracowania na studia” ma masę użyć, ale ludzie wychodzą po jednym przebiegu, masz konkretne, działające dane o porażkach. To lepsze niż kolejny zrzut ekranu z detektora.

-

Dodaj porównanie „Mój głos vs. zhumanizowany głos”

Tu trochę nie zgadzam się z mocnym naciskiem na detektory: w dłuższym okresie ludziom bardziej zależy na głosie niż na 0% AI. Jeśli tekst przestaje brzmieć jak oni, porzucą narzędzie, nawet jeśli jest „niewykrywalne”.

Pozwól użytkownikom:

- Wkleić oryginalny tekst

- Otrzymać wynik po humanizacji

- Zobaczyć szybkie porównanie w stylu diff:

- „Formalność: +20%”

- „Osobisty ton: -30%”

- „Długość zdań: +15%”

Następnie wprost zapytaj:

„Czy to nadal brzmi jak Ty?” [Tak / Trochę / Nie]

Samo to pytanie da Ci bardziej szczery sygnał niż „Oceń w skali 1–5”.

-

Potrzebujesz negatywnych zachęt, nie tylko łapówek

Wszyscy mówią o kartach podarunkowych, perkach w becie itd. Problem: ludzie będą mówić to, co chcesz usłyszeć, żeby utrzymać benefity.

Spróbuj:

- „Jeśli wyślesz nam 3 naprawdę słabe wyniki (zrzuty lub fragmenty), odblokujemy X dodatkowych kredytów.”

- Nagradzanie nie za „częste używanie narzędzia”, ale za „pokazanie, gdzie zawodzi”.

To utrzymuje fokus na słabych punktach, zamiast na mglistych „tak, jest spoko, dzięki”.

-

Stwórz wewnętrzne „Hall of Shame”

Wiesz już, że narzędzie potrafi działać dobrze w idealnych warunkach. Czego nie masz, to zebranej kupki:

- Najgorszych wyników

- Najbardziej niezręcznych zdań

- Przypadków, gdy zmienił znaczenie

- Przypadków, gdy sprawił, że użytkownik brzmi jak generyczny bloger AI

Raz w tygodniu wyciągnij:

- 50 sesji z największą liczbą szybkich regeneracji

- 50 z najszybszym zamknięciem po wyświetleniu wyniku

Ręcznie przejrzyj 10–20 i oznacz, czemu były słabe. Z tych wzorców się rozwijasz.

-

Wymuś odrobinę tarcia w jednym miejscu lejka

Pewnie optymalizujesz pod „bez logowania, super szybko, zero tarcia”. Świetne dla ruchu, fatalne dla feedbacku.

Rozważ osobny „sandbox Pro z feedbackiem”:

- Wymaga maila lub prostego logowania

- Daje wyższe limity lub dodatkowe tryby

- W zamian użytkownicy:

- Zaznaczają 2 pola przy każdym wyniku: „Naturalne / Robotyczne” i „Na temat / Odpłynęło”

- Opcjonalnie wklejają kontekst typu „Użyłem do [szkoła / praca / social media]”

Osoby, które poświęcą 20 sekund na rejestrację, są znacznie bardziej skłonne dawać prawdziwy feedback niż przypadkowi odwiedzający.

-

Wbuduj oczekiwania bezpośrednio w UI

Lekka niezgoda z niepisanym założeniem, które możesz mieć: „Jeśli jest wystarczająco dobre, użytkownik powinien móc kliknąć kopiuj i odejść.” Tak ludzie nie korzystają z takich narzędzi.

Po prostu dodaj tekst:

„To narzędzie doprowadzi Cię do 70–90% gotowego tekstu. Musisz dać mu szybkie ludzkie przeczytanie przed wysłaniem.”

Potem zapytaj wprost:

- „Czy musiałeś to jeszcze dużo edytować?” [Trochę / Dużo / Przepisałem prawie wszystko]

To szczery feedback, który nie wymaga długiej ankiety.

- „Czy musiałeś to jeszcze dużo edytować?” [Trochę / Dużo / Przepisałem prawie wszystko]

-

Wykorzystaj porównanie z konkurencją bez cringy marketingu

Skoro ludzie i tak próbują narzędzi typu humanizer Grammarly, Ahrefs, Undetectable itp., możesz to wykorzystać, zamiast udawać, że nie istnieją.

Dodaj małe pole wyboru:

- „Czy korzystałeś z podobnych narzędzi (jak humanizery AI od Grammarly lub Ahrefs)?

- Tak, to jest lepsze

- Tak, to jest gorsze

- Mniej więcej to samo

- Nie, nie używałem innych”

Bez jechania po markach, bez „jesteśmy najlepsi”. Tylko dane.

Użyj tego do zrozumienia pozycjonowania, nie tylko jakości. - „Czy korzystałeś z podobnych narzędzi (jak humanizery AI od Grammarly lub Ahrefs)?

-

Przestań zakładać, że sukces w detektorach = sukces produktu

Biorąc pod uwagę to, co pokazał @mikeappsreviewer, Twój Clever AI Humanizer już wypada solidnie na tle publicznych detektorów. Super. Ale zapytaj:

- „Gdyby wszystkie detektory zniknęły jutro, czy moje narzędzie nadal byłoby warte używania?”

Jeśli szczera odpowiedź brzmi „raczej nie”, to roadmapa powinna przechylić się w stronę:

- Personalizacji

- Kontroli tonu

- Bezpieczeństwa (bez halucynacji, bez nieprawdziwych stwierdzeń)

- Zachowania oryginalnego sensu

To są rzeczy, które przetrwają, gdy wyścig zbrojeń wokół detektorów przycichnie.

-

Świadomie pozycjonuj Clever AI Humanizer jako narzędzie współpracy

Dostaniesz dużo lepszy feedback, jeśli przestaniesz udawać, że to peleryna niewidka.

Przykład w UI:

„Szkic od AI, dopracowany przez Clever AI Humanizer, wykończony przez Ciebie.”

To ustawia użytkownika tak, by myślał:

- „W czym mi to pomogło?”

- „Gdzie mi to utrudniło życie?”

Pytaj o feedback w tym kontekście:

- „Czy Clever AI Humanizer zaoszczędził Ci czas przy tym zadaniu?” [Tak / Nie]

- „Czy zmienił Twoje znaczenie?” [Tak / Nie]

Część wspólna „Nie zaoszczędził czasu” + „Zmienił znaczenie” to miejsca, gdzie najbardziej zawodzisz.

Jeśli chcesz ruch, który naprawdę możesz wdrożyć w jeden dzień:

- Po każdym wyniku pokaż 3 przyciski:

- „Wysłałbym to w tej formie”

- „Użyję, ale trochę przeredaguję”

- „To się nie nadaje”

- Jeśli wybiorą ostatni, jedno pytanie pomocnicze:

- „Zbyt robotyczne / Poza tematem / Niewłaściwy ton / Słaby angielski / Inne”

Taki mały flow, w skali, powie Ci więcej o realnej skuteczności Clever AI Humanizer niż kolejny miesiąc testów na detektorach albo pytania innych modeli LLM, czy dały się „oszukać”.

Szybka analiza z innej perspektywy, skoro inni już dokładnie omówili UX i testowanie:

1. Traktuj „prawdziwy feedback” jako dane, nie opinie

Zamiast kolejnych eksperymentów z detektorami, podepnij twarde metryki wokół Clever AI Humanizer:

Kluczowe wskaźniki do śledzenia:

- Współczynnik ukończenia: tekst wklejony → humanize → kopiuj.

- Liczba ponownych generacji na jedno wejście: wiele regeneracji = niezadowolenie.

- Czas do skopiowania: jeśli ludzie kopiują w ciągu 2–5 sekund, nie czytają, tylko farmią.

- Intencja edycji: klik „Kopiuj z formatowaniem” vs „Kopiuj jako zwykły tekst” vs „Pobierz”. Różne wzorce zwykle odpowiadają różnym zastosowaniom.

To daje ci cichy feedback z każdej sesji, nie tylko od garstki osób gotowych pisać ci długie akapity.

2. Lekka segmentacja użytkowników (cohort labeling)

Inni sugerowali persony. Ja uprościłbym to do bólu:

Przy pierwszym użyciu jednoklikowy wybór nad polem:

- „Używam do: Szkoła / Praca / Social / Inne”

Bez logowania, bez tarcia. Po prostu zapisz anonimową etykietę kohorty.

Wtedy możesz zobaczyć:

- Szkoła: najwyższa liczba regeneracji i porzuceń

- Praca: najdłuższy czas na stronie, ale wysoki współczynnik kopiowania

- Social: szybkie kopiowanie, mała długość, być może nie warte mocnej optymalizacji

Już nie zgadujesz, którą grupę odbiorców zawiodłeś.

3. A/B test „agresywnej vs zachowawczej” humanizacji

Obecnie Clever AI Humanizer wydaje się zoptymalizowany pod omijanie detektorów plus czytelność. To w porządku, ale różni użytkownicy chcą różnego poziomu ingerencji w tekst.

Uruchom cichy test A/B:

- Wersja A: minimalne zmiany, zachowana struktura, lekka parafraza

- Wersja B: mocniejsze przepisanie, większa różnorodność, większe zmiany rytmu

Następnie porównaj:

- Która wersja generuje więcej zachowań „kopiuj i wyjdź”

- Która wersja skutkuje większą liczbą kliknięć „Uruchom ponownie”

Bez ankiet, bez proszenia o opinię. Zachowanie daje odpowiedź.

4. Plusy / minusy jako test rzeczywistości produktu

W porównaniu z tym, co opisali @kakeru i @andarilhonoturno, uważam, że twój tool już jest w kategorii „lepszy niż przeciętny”, ale warto nazwać rzeczy wprost:

Plusy Clever AI Humanizer

- Mocne wyniki wobec popularnych detektorów AI w realistycznych treściach.

- Output na ogół czyta się naturalnie i poprawnie, bez wymuszonego „spamu literówek”, jaki stosują niektóre narzędzia.

- Wiele stylów (Simple Academic, Casual itd.), które całkiem dobrze odpowiadają rzeczywistym sytuacjom pisania.

- Zintegrowany AI writer, który może generować i humanizować w jednym przebiegu, co zmniejsza oczywiste ślady LLM.

- Darmowy i lekki onboarding, co jest świetne na wczesnym etapie i dostarcza dużo danych do testów.

Minusy Clever AI Humanizer

- Słaba kontrola nad liczbą słów, co jest realnym problemem przy sztywnych wymaganiach zadań i briefów.

- Czasem zbyt agresywnie przepisuje, wprowadzając dryf treści, którego użytkownik nie zawsze wychwyci.

- Nawet przy 0% AI w detektorach część tekstów nadal „czuć” maszynową strukturą i rytmem.

- Propozycja wartości oparta na detektorach wciąga cię w niekończącą się grę w kotka i myszkę i może słabo się zestarzeć.

- Mało wyraźnej personalizacji stylu, więc stali użytkownicy mogą mieć wrażenie, że ich teksty zaczynają brzmieć podobnie.

5. Przestań dopasowywać się do detektorów, zacznij dopasowywać się do stałych użytkowników

Tu trochę nie zgadzam się z mocnym naciskiem na detektory, który widać w testach @mikeappsreviewer. Zrzuty z detektorów są przydatne marketingowo, ale to kruche cele produktowe.

Bardziej trwałe sygnały:

- Ilu użytkowników wraca w ciągu 7 dni

- Wśród powracających, w ilu przypadkach rośnie liczba słów na sesję (sygnał zaufania)

- Jak często ta sama przeglądarka / IP używa narzędzia w różnych kontekstach (szkoła + praca itd.)

Prawdziwi użytkownicy nie zostają dlatego, że detektor pokazał „0% AI”. Zostają, bo:

- Zaoszczędziło im to czas.

- Nie wystawiło ich na wstyd.

- Nie zmieniło tego, co chcieli powiedzieć.

Najpierw optymalizuj pod zachowania powracających użytkowników, dopiero potem pod wyniki w detektorach.

6. Buduj „wzorzec zaufania”, a nie „wzorzec maskowania”

Nie musisz pokonać każdego przyszłego detektora. Powinieneś być narzędziem, które:

- Nie narusza znaczenia.

- Pozwala regulować ton.

- Jasno komunikuje ograniczenia.

Delikatne, ale opłacalne ulepszenie w UI:

- Po wygenerowaniu wyniku wyświetl krótkie, uczciwe podsumowanie typu:

- „Zachowanie znaczenia: wysokie”

- „Zmiana tonu: umiarkowana”

- „Zmiana struktury zdań: wysoka”

Ludzie zaczynają ci ufać, bo pokazujesz, jak pracujesz. To zaufanie pośrednio daje ci lepszy feedback niż jakakolwiek ankieta.

7. Jak zdobyć jakościowy feedback bez męczenia użytkownika

Wykorzystaj wyzwalacze zależne od zachowania:

-

Jeśli użytkownik wykona 3+ regeneracje na tym samym wejściu:

- Pokaż mały, wbudowany prompt:

- „Nie dostajesz tego, czego potrzebujesz? Opisz w 5 słowach.” [małe pole tekstowe]

To przynosi brutalnie szczere komentarze typu „zbyt robotyczne”, „zmieniło moją tezę”, „za rozwlekłe”.

- „Nie dostajesz tego, czego potrzebujesz? Opisz w 5 słowach.” [małe pole tekstowe]

- Pokaż mały, wbudowany prompt:

-

Jeśli użytkownik spędzi >40 sekund edytując tekst w twoim polu przed humanizacją:

- Zapytaj: „Poprawiasz tekst AI czy szlifujesz własne pisanie?”

To pomaga zrozumieć, czy Clever AI Humanizer jest postrzegany bardziej jako „naprawiacz AI” czy „edytor”, co ma znaczenie dla roadmapy.

- Zapytaj: „Poprawiasz tekst AI czy szlifujesz własne pisanie?”

Bez dużych modalów, bez „oceń nas na 5 gwiazdek”, tylko małe, kontekstowe „szturchnięcia”.

8. Gdzie konkurenci mieszczą się w twoim modelu mentalnym

Masz już dobre porównania od osób takich jak @kakeru i bardziej „detektorowego” przeglądu od @mikeappsreviewer. Traktuj je jako benchmarki, ale nie jako gwiazdę polarną.

Traktuj inne narzędzia jako przykłady:

- „Tak wygląda efekt, gdy maksujesz omijanie detektorów i ignorujesz głos autora.”

- „Tak wygląda efekt, gdy robisz lekką parafrazę, pozostajesz bezpieczny, ale wykrywalny.”

Przewaga Clever AI Humanizer polega na próbie zbalansowania czytelności i wykrywalności. Twoja kolejna przewaga powinna polegać na personalizacji i kontroli, a nie tylko na niższych procentach w kolejnym publicznym detektorze.

Jeśli chcesz jedno konkretne wdrożenie na ten tydzień, które jednocześnie poprawi produkt i da ci realne sygnały z użycia:

- Dodaj dwa przełączniki przed humanizacją:

- „Zachowaj strukturę tak bardzo, jak to możliwe”

- „Zmień strukturę dla bardziej ludzkiej różnorodności”

Następnie loguj, która kombinacja przełączników koreluje z:

- Wyższym współczynnikiem kopiowania

- Mniejszą liczbą regeneracji

- Większą liczbą powrotów

Bardzo szybko się dowiesz, jakiego rodzaju „humanizacji” twoi realni użytkownicy naprawdę chcą, zamiast zgadywać na podstawie wykresów z detektorów.