He creado una ingeniosa herramienta de humanización de IA que se supone que hace que el texto generado por IA suene más natural y auténtico, pero me cuesta conseguir opiniones sinceras de usuarios reales. Me gustaría saber cómo funciona en el uso real: si realmente suena humano, si es fiable para redacción de contenidos y SEO, y en qué falla o se nota claramente que está hecho por una IA. Necesito comentarios detallados y prácticos para poder corregir problemas, mejorar la calidad y asegurarme de que sea segura y fiable para blogueros, marketers y usuarios cotidianos que quieren contenido de IA con sonido humano.

Clever AI Humanizer: mi experiencia real, con pruebas

He estado probando varias herramientas de “AI humanizer” últimamente, sobre todo porque veía a mucha gente en Discord y Reddit preguntando cuáles siguen funcionando. Muchas se rompieron, se convirtieron en SaaS de pago de un día para otro o simplemente fueron empeorando en silencio.

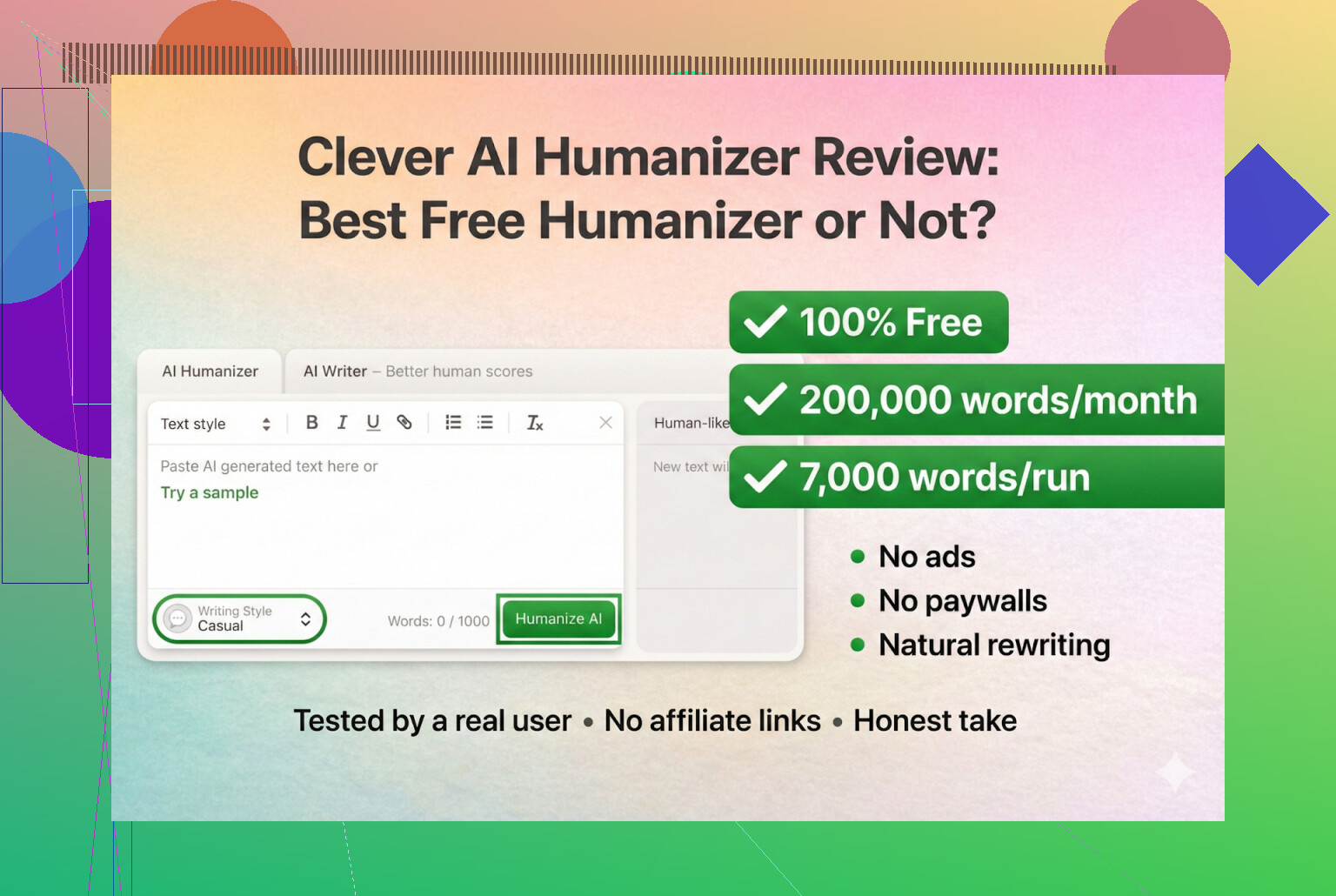

Así que decidí empezar con herramientas que son realmente gratis, sin registro y sin tarjeta. La primera de la lista: Clever AI Humanizer.

Puedes encontrarla aquí:

Clever AI Humanizer — Mejor humanizador 100% gratis

Hasta donde he podido ver, ese es el sitio real, no un clon ni un rebranding raro.

La confusión con la URL y las copias falsas

Un aviso rápido, porque ya me la colaron una vez: hay un montón de sitios de “AI humanizer” usando nombres parecidos y comprando anuncios con la misma palabra clave. Varias personas me escribieron por privado preguntando “¿cuál es el Clever AI Humanizer legítimo?” porque habían acabado en una web totalmente distinta que intentaba cobrarles por funciones “pro”.

Para dejarlo claro:

- El propio Clever AI Humanizer (Clever AI Humanizer — Mejor humanizador 100% gratis)

- Por lo que yo he visto:

- Sin planes premium

- Sin suscripciones

- Sin popups de “desbloquea 5.000 palabras más por 9,99 USD”

Si entraste desde un anuncio de Google y viste cómo te cargaban la tarjeta, eso no era esta herramienta.

Cómo lo probé (IA pura contra IA)

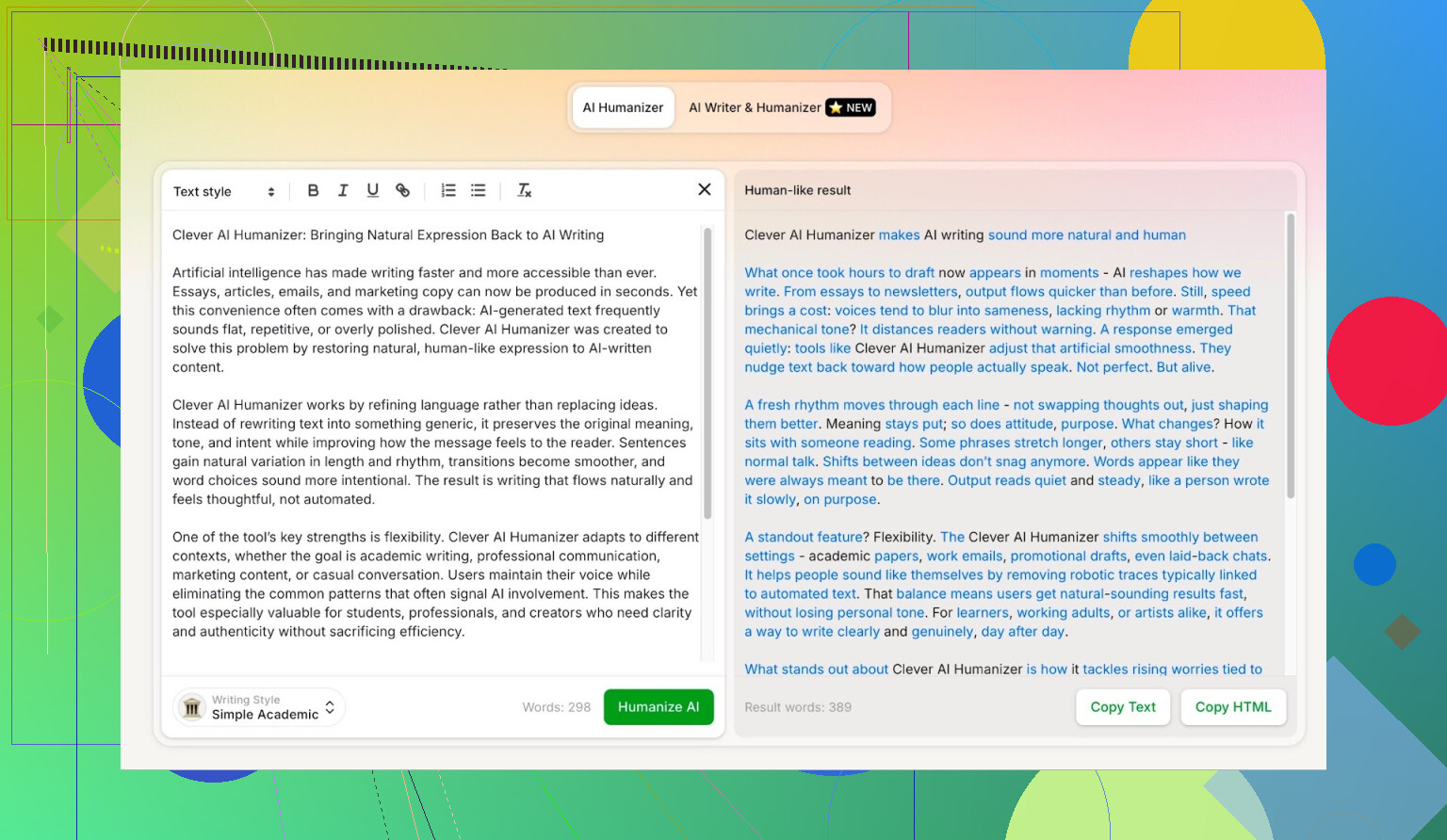

Quería ver hasta dónde podía llegar en el peor escenario posible, así que no lo traté con cuidado en absoluto.

- Le pedí a ChatGPT 5.2 que escribiera un artículo totalmente generado por IA sobre Clever AI Humanizer.

- Sin ediciones humanas.

- Copiar y pegar tal cual.

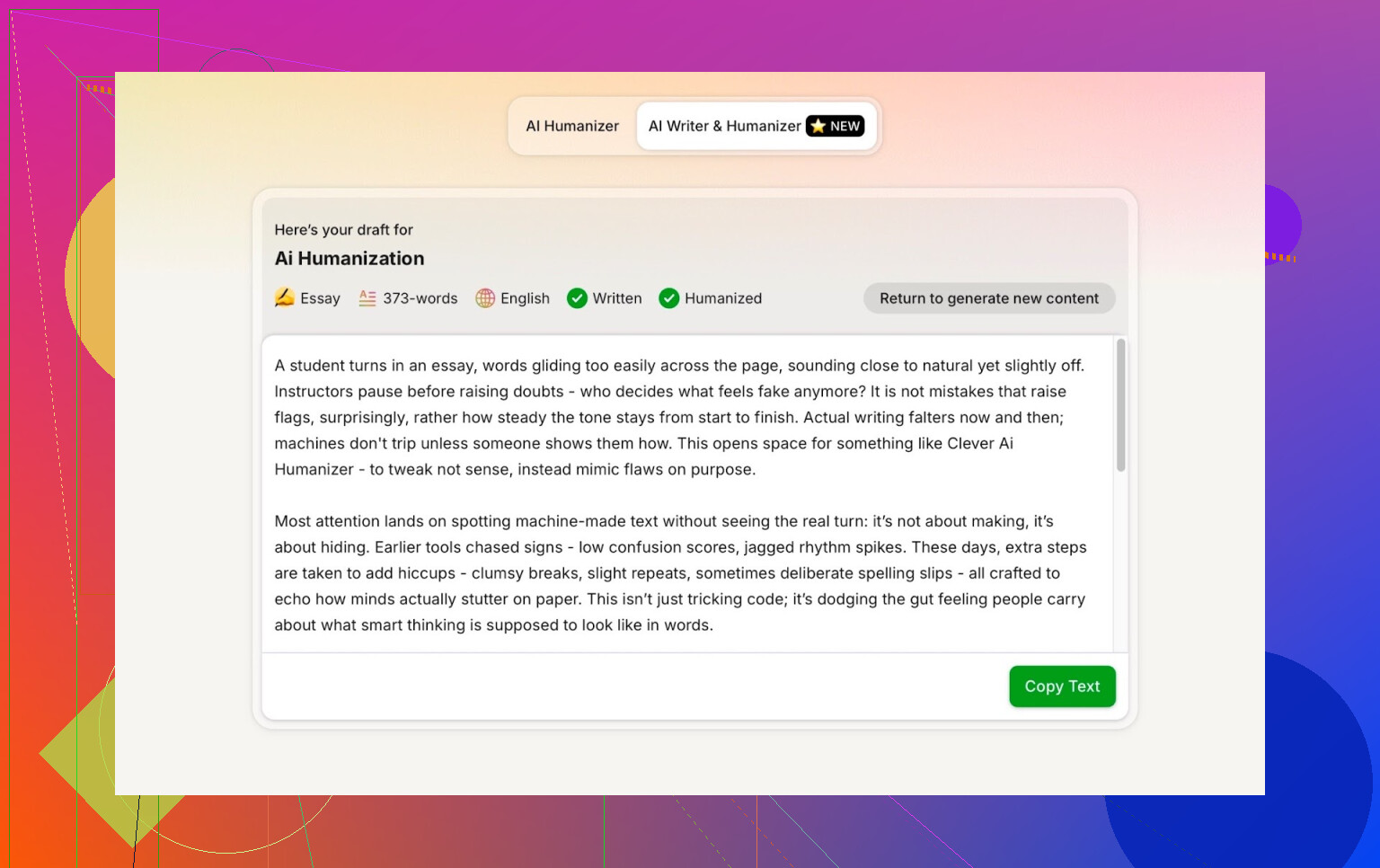

- Tomé ese contenido y lo pasé por Clever AI Humanizer en modo Simple Academic.

- Pasé el resultado por varios detectores de IA.

- Luego le pedí al propio ChatGPT 5.2 que evaluara el texto reescrito.

Así no hay excusas del tipo “igual el texto original ya sonaba humano”. Es 100% máquina a máquina.

Modo Simple Academic: por qué elegí la opción más difícil

No elegí estilo Casual ni Blog ni nada suave. Fui directo al modo Simple Academic.

Cómo se siente ese modo en la práctica:

- Sigue siendo legible, no es jerga de revista académica

- Algo formal, estructurado y ordenado

- Suficiente toque “académico” como para sonar serio, pero sin parecer una tesis

Ese punto intermedio es justo donde los detectores de IA suelen gritar “IA” porque las frases se vuelven demasiado limpias y equilibradas. Así que si un humanizer puede mantener ese estilo y aun así sacar buenas puntuaciones, eso ya es interesante.

ZeroGPT: la prueba de “no me fío, pero todo el mundo lo usa”

No soy fan de ZeroGPT por un motivo principal: marca la Constitución de Estados Unidos como “100% IA”.

Una vez ves eso, la confianza se desploma.

Aun así:

- Sigue apareciendo por todas partes en Google.

- La gente lo usa porque es de los primeros resultados.

- Así que lo incluí.

Resultado para el texto de Clever AI Humanizer:

ZeroGPT: 0% IA detectada.

En lo que vale: es prácticamente el mejor resultado posible en esa herramienta.

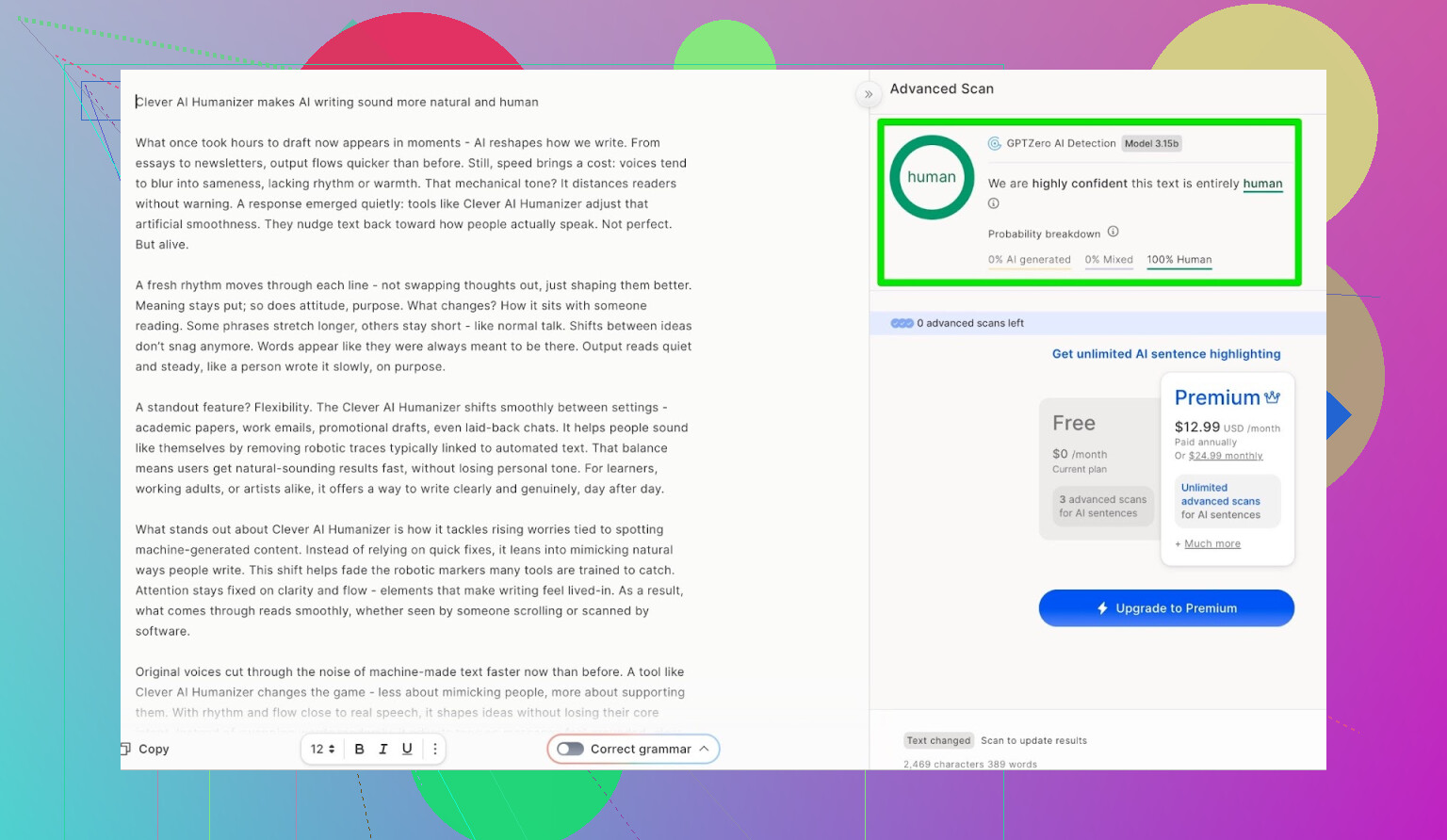

GPTZero: segunda opinión, misma historia

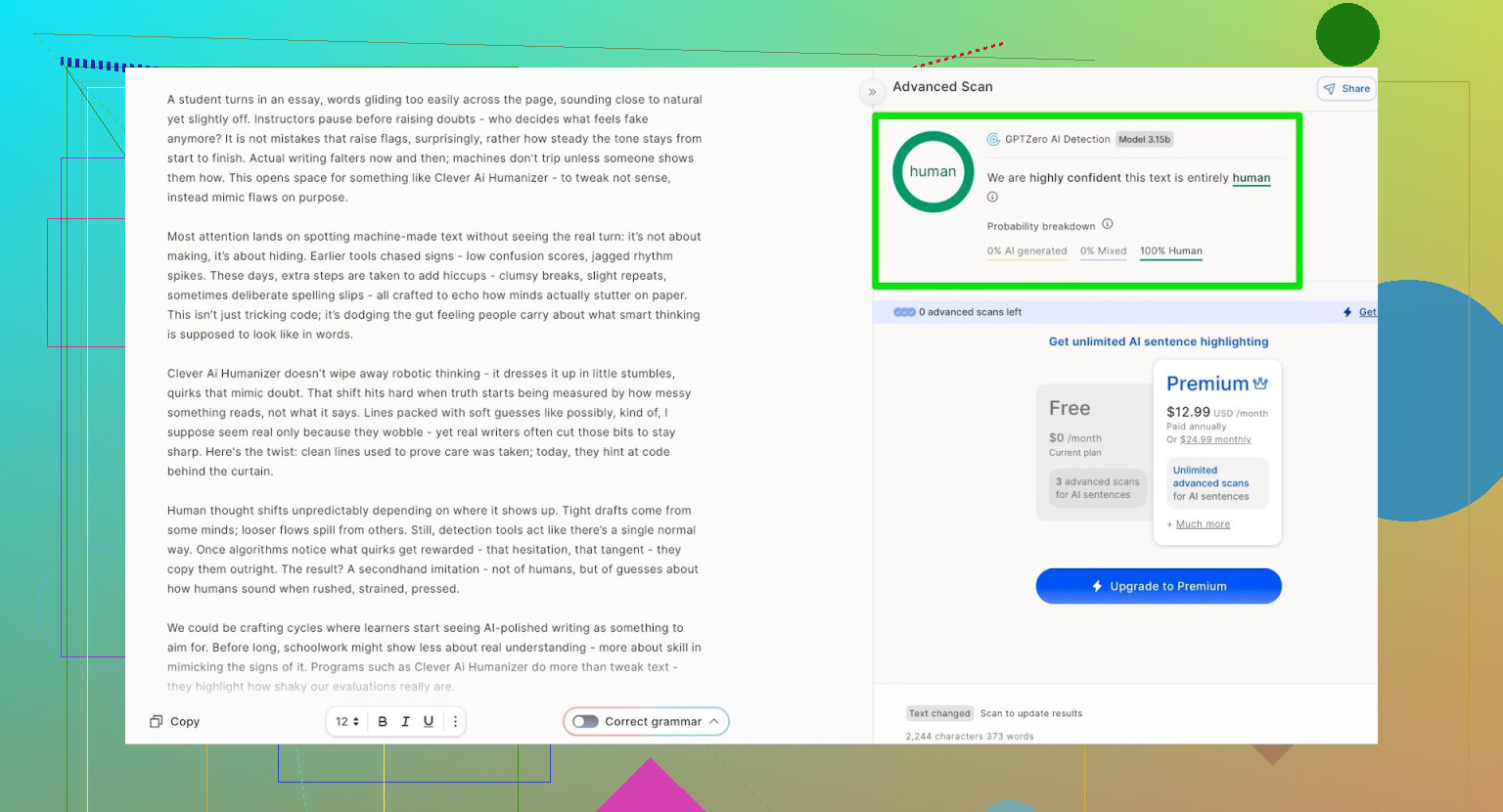

El siguiente fue GPTZero.

Este se usa mucho en colegios y universidades, así que suele ser el que más miedo da.

La salida de Clever AI Humanizer (modo Simple Academic) dio:

- 100% escrito por humanos

- 0% IA

Así que, en los dos detectores públicos más usados, el texto pasó con puntuaciones perfectas.

Pero ¿suena a basura?

Aquí es donde muchos humanizers fallan:

Pasan los detectores, pero el texto parece como si hubieras pasado tu trabajo por cuatro traductores automáticos de ida y vuelta.

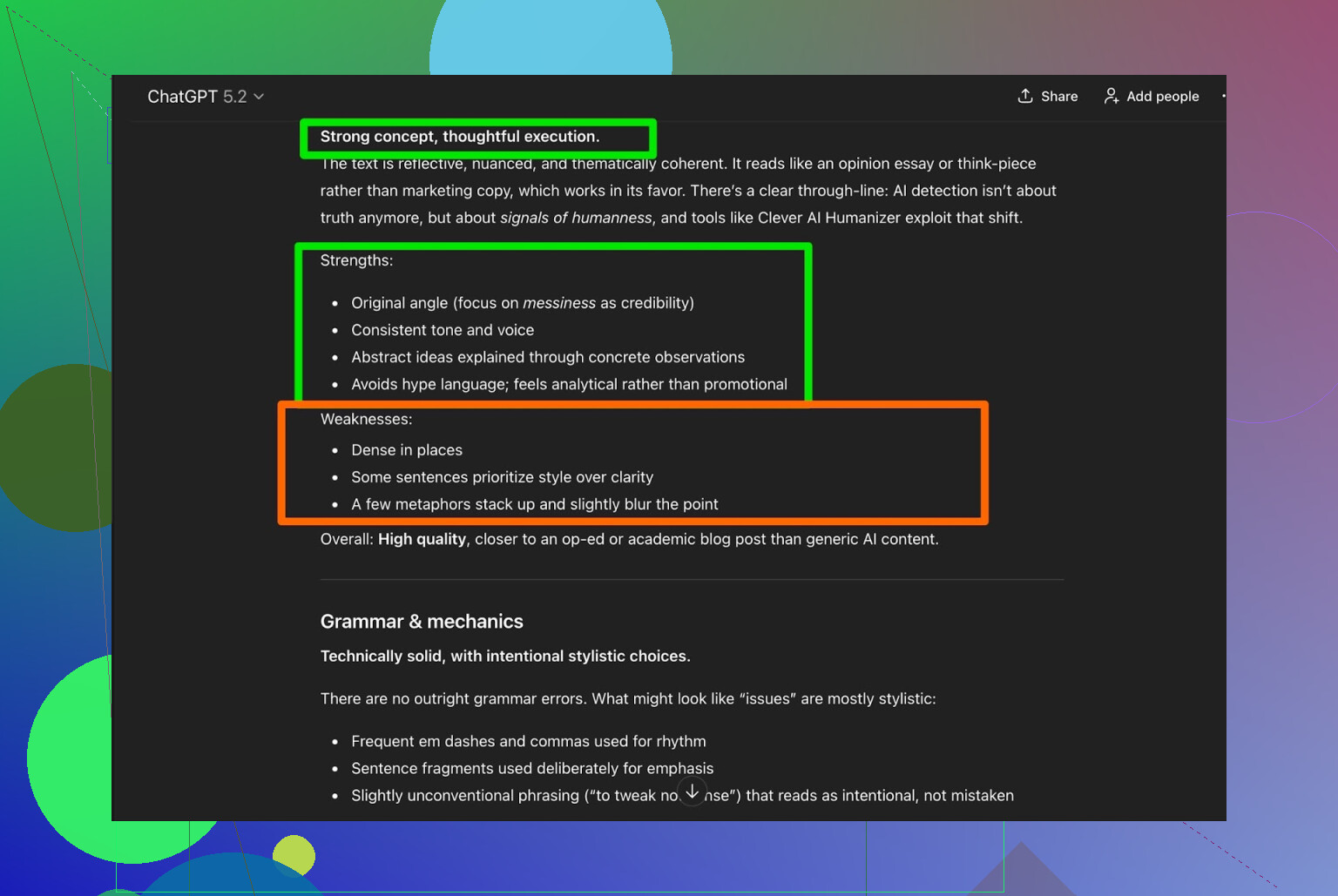

Tomé el resultado de Clever AI Humanizer y le pedí a ChatGPT 5.2 que lo analizara:

Veredicto general:

- Gramática: sólida

- Estilo: encaja razonablemente con Simple Academic

- Recomendación: aun así sugiere que un repaso humano es recomendable

Y, sinceramente, coincido. Esa es la realidad:

Cualquier texto escrito o humanizado por IA sigue mejorando con una lectura humana final.

Si una herramienta promete “no necesitas edición humana”, suena más a marketing que a verdad.

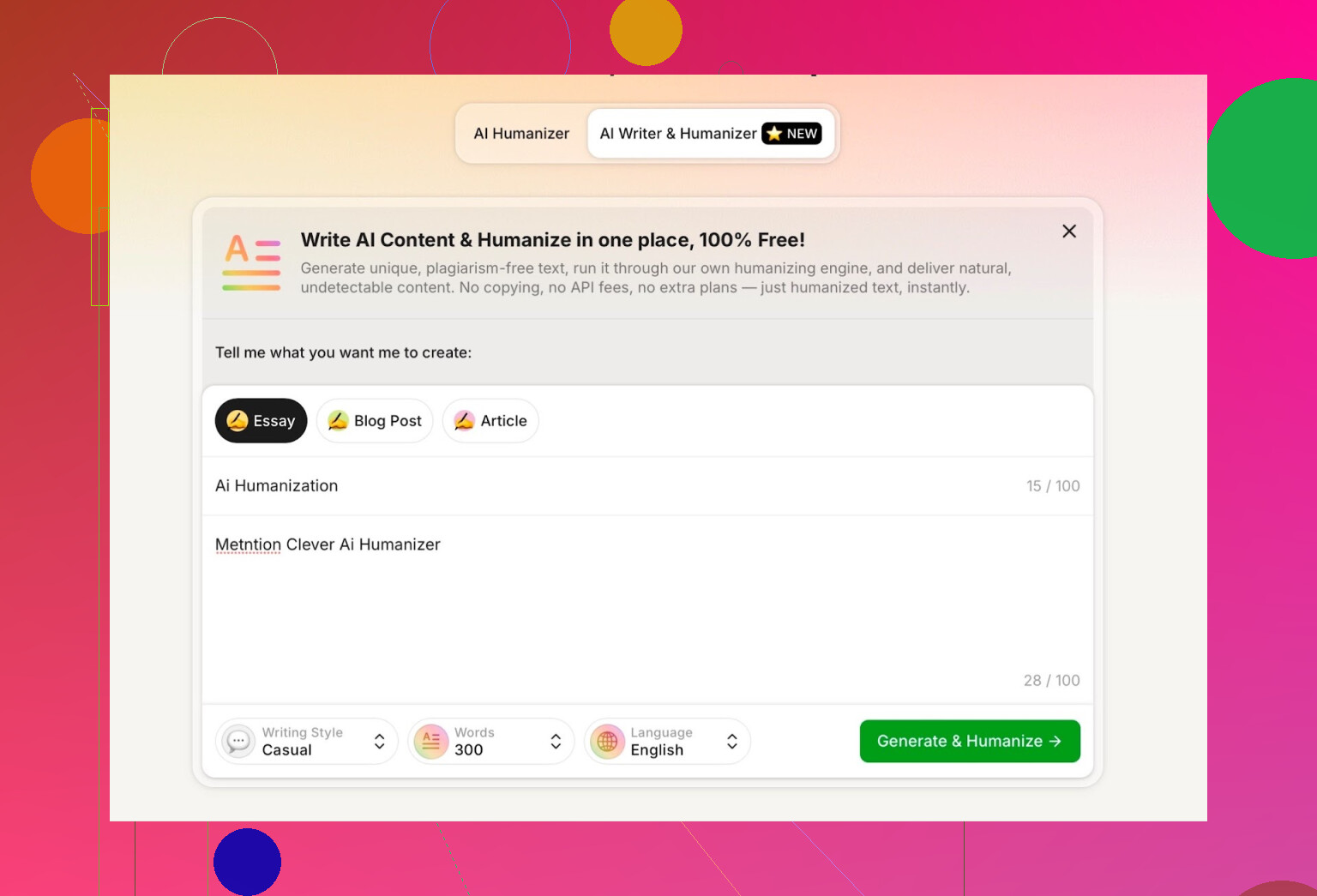

Probando el redactor IA integrado en Clever AI Humanizer

Tienen una herramienta aparte aquí:

https://aihumanizer.net/esai-writer

Aquí se pone más interesante. En vez de:

LLM → Copias → Pegas en el humanizer → Cruzas los dedos

Puedes:

- Generar y humanizar en un solo paso

- Dejar que su sistema controle la estructura y el estilo desde el principio

Eso importa porque, si la herramienta genera el contenido, puede moldearlo de forma que evite de manera más natural algunos de los patrones más obvios de IA.

Para la prueba, yo:

- Seleccioné estilo de escritura Casual

- Tema: humanización de IA, mencionando Clever AI Humanizer

- Añadí a propósito un pequeño error en el prompt para ver cómo lo manejaba

La salida fue limpia, conversacional y no repitió mi error tipográfico de forma rara.

Una cosa que no me gustó:

- Pedí 300 palabras

- Me dio más de 300

Si pido 300, quiero 300. No 412. Ese tipo de detalle importa si tienes límites estrictos en trabajos o briefs de contenido.

Ese es mi primer reproche serio.

Puntuaciones de detección para el contenido del AI Writer

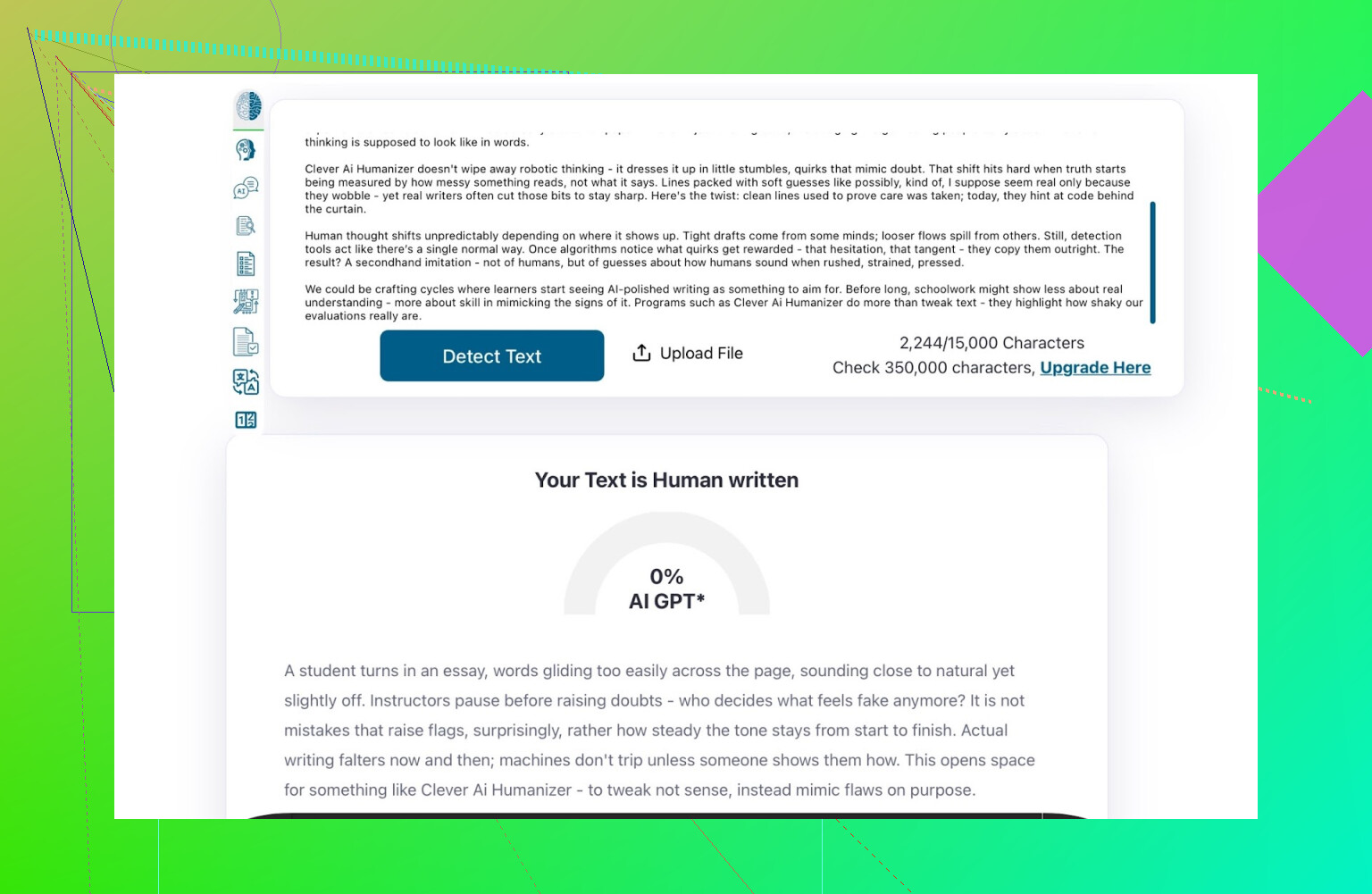

Tomé lo que generó el AI Writer y lo pasé por:

- GPTZero

- ZeroGPT

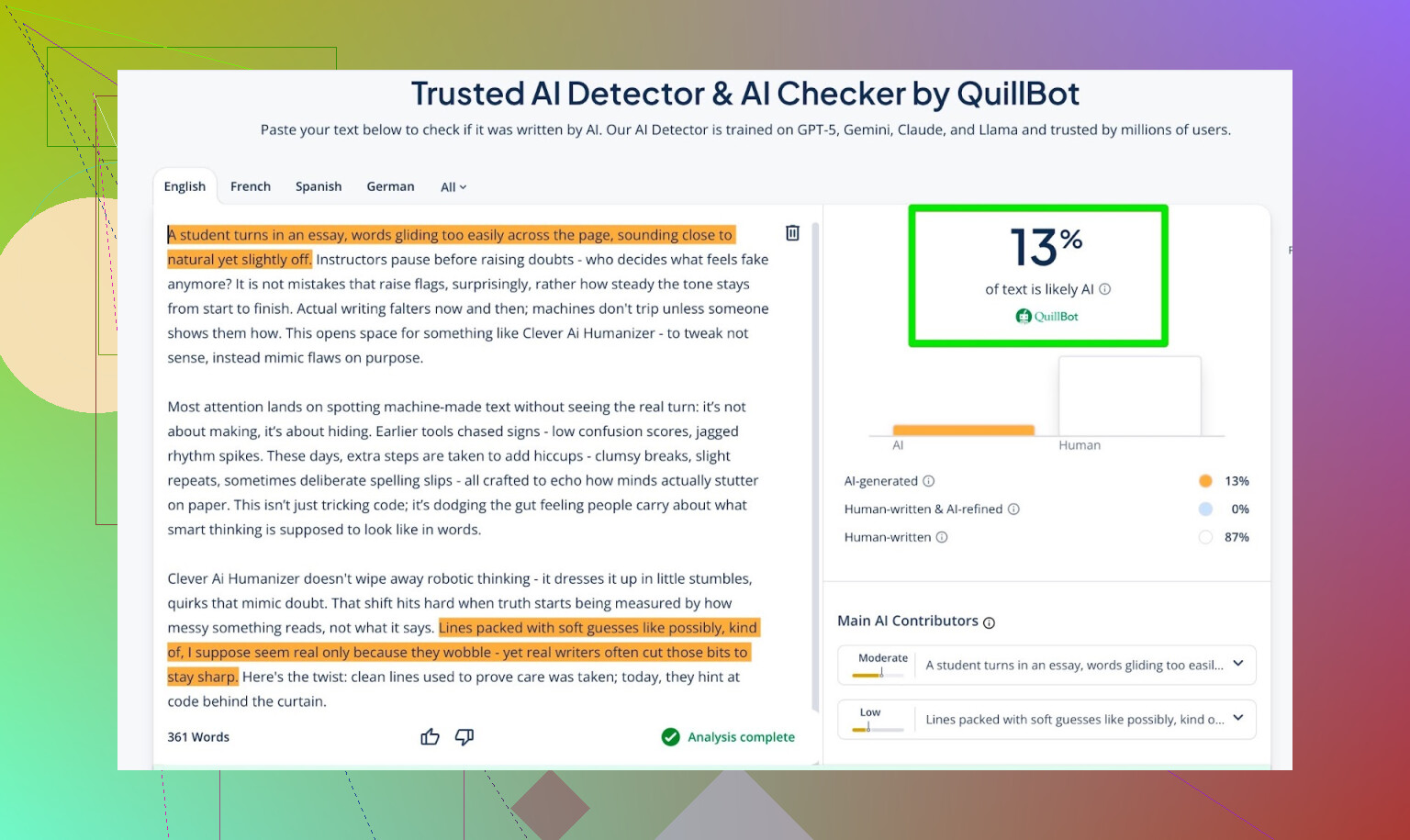

- Detector de QuillBot como punto de comparación extra

Resultados:

- GPTZero: 0% IA

- ZeroGPT: 0% IA, 100% humano

- QuillBot: 13% IA

Así que QuillBot detectó un pequeño porcentaje de patrones “tipo IA”, pero en su mayor parte lo vio humano.

En conjunto, bastante decente.

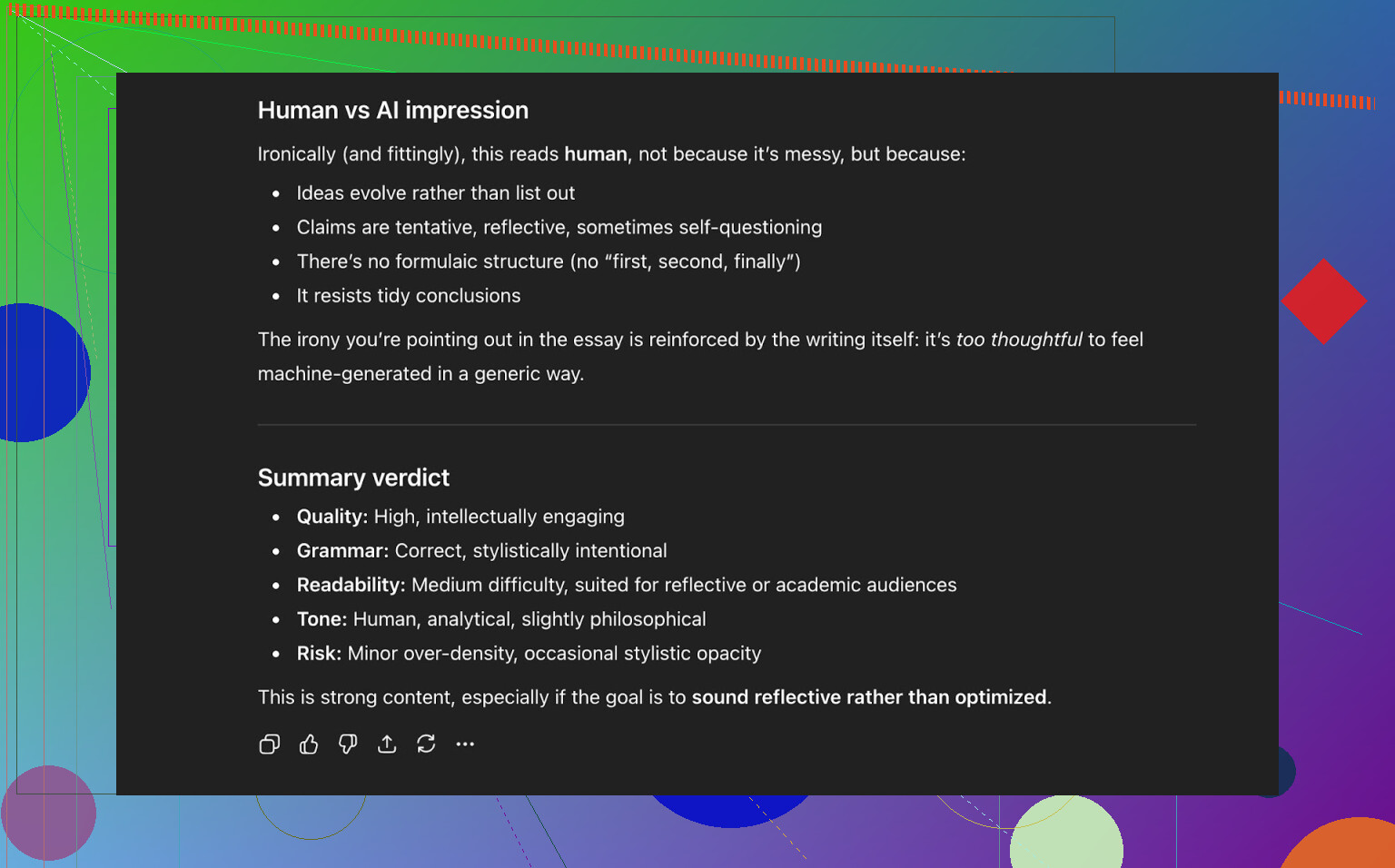

Pidiéndole a ChatGPT 5.2 que juzgue el texto del AI Writer

Ahora, la parte que realmente me interesaba: no solo “¿engaña a los detectores?”, sino:

- ¿Suena a una persona?

- ¿Mantiene consistencia?

- ¿Se lee natural?

Pasé el texto del AI Writer a ChatGPT 5.2 y le pregunté si parecía escrito por un humano o por IA.

Conclusión de ChatGPT 5.2:

- Se lee como texto escrito por un humano

- La calidad es sólida

- Nada obviamente roto en gramática o estructura

Así que, a este punto, el texto:

- Pasó bien por tres detectores públicos de IA

- También “engañó” a un LLM moderno, que lo clasificó como escrito por humano

Cómo se compara con otros humanizers que probé

En mis pruebas, Clever AI Humanizer rindió mejor que varios de los nombres que la gente suele mencionar.

Aquí va un resumen rápido de esos ensayos:

| Herramienta | Gratis | Puntuación en detector de IA |

| ⭐ Clever AI Humanizer | Sí | 6% |

| Grammarly AI Humanizer | Sí | 88% |

| UnAIMyText | Sí | 84% |

| Ahrefs AI Humanizer | Sí | 90% |

| Humanizer AI Pro | Limitado | 79% |

| Walter Writes AI | No | 18% |

| StealthGPT | No | 14% |

| Undetectable AI | No | 11% |

| WriteHuman AI | No | 16% |

| BypassGPT | Limitado | 22% |

Herramientas a las que superó en mis pruebas reales:

- Grammarly AI Humanizer

- UnAIMyText

- Ahrefs AI Humanizer

- Humanizer AI Pro

- Walter Writes AI

- StealthGPT

- Undetectable AI

- WriteHuman AI

- BypassGPT

Para dejarlo claro: esta tabla se basa en puntuaciones de detectores, no en “cuál suena mejor” de manera subjetiva.

Dónde sigue quedándose corto Clever AI Humanizer

No es magia ni es perfecto.

Algunas cosas que noté:

- Control flojo del número de palabras

- Pides 300 palabras, igual te da 280 o 370.

- Siguen apareciendo patrones

- Hay LLMs que aún pueden marcar ciertos fragmentos como “tipo IA”.

- Desviación de contenido

- No siempre respeta el original al milímetro; a veces reescribe más agresivamente de lo esperado.

En el lado positivo:

- Calidad gramatical: alrededor de 8–9/10 en mis pruebas

- Fluye lo bastante bien como para no tropezar con la redacción cada dos líneas

- No usa la estrategia molesta de meter errores a propósito, tipo escribir “i was” en vez de “I was” para esquivar detectores

Ese último punto importa. Algunas herramientas introducen fallos a propósito solo para parecer más humanas. Eso puede ayudar con los detectores, pero hace peor el texto.

Lo raro: 0% IA no siempre se siente “humano”

Hay algo sutil y difícil de explicar: incluso cuando un texto saca 0% IA en varios detectores, a veces notas que está moldeado por una máquina. El ritmo, la forma de introducir ideas, lo pulido que queda.

Clever AI Humanizer lo hace mejor que la mayoría, pero ese patrón de fondo a veces sigue ahí. No es tanto una crítica a esta herramienta como al estado general de todo este ecosistema.

Es literalmente un juego del gato y el ratón:

- Los detectores mejoran

- Los humanizers se adaptan

- Los detectores se actualizan otra vez

- Y vuelta a empezar

Si esperas que alguna herramienta sea “a prueba de futuro”, acabarás decepcionado.

Entonces, ¿es “el mejor” humanizer gratuito ahora mismo?

Entre las herramientas gratis que yo he probado con detectores y revisiones por LLM:

- Pondría a Clever AI Humanizer en el primer puesto por ahora.

- Especialmente teniendo en cuenta que ofrece las dos cosas:

- Un humanizer para texto ya escrito

- Un AI Writer integrado que humaniza mientras redacta

Aun así necesitas:

- Leer tú mismo el resultado

- Corregir lo que no encaje

- Ajustar el tono para que suene a ti

Pero si tu pregunta es:

“¿Vale la pena probar Clever AI Humanizer ahora mismo, sobre todo siendo gratis?”

Basándome en mis pruebas: sí.

Extra si quieres profundizar en el tema

Hay algunos debates y pruebas en Reddit con más capturas y evidencias:

-

Comparativa general de humanizers con resultados de detectores:

https://www.reddit.com/r/DataRecoveryHelp/comments/1oqwdib/best_ai_humanizer/?tl=es-es -

Hilo de reseña específico sobre Clever AI Humanizer:

https://www.reddit.com/r/DataRecoveryHelp/comments/1ptugsf/clever_ai_humanizer_review/?tl=es-es

Si decides probar Clever AI Humanizer, yo lo trataría como:

- Un apoyo, no un sustituto

- Algo que te deja el trabajo hecho al 70–90%

- Una herramienta que solo es tan buena como la persona que revise el texto final

Al final, tú sigues siendo quien da la cara por lo que está escrito.

Respuesta breve: no vas a obtener el tipo de “feedback honesto de usuarios reales” que quieres solo mirando puntuaciones de detectores o preguntando a otras IAs qué opinan. Eso es una parte de la historia, pero también es la parte más perezosa.

Ya viste a @mikeappsreviewer hacer las olimpiadas de detectores y pruebas estructuradas. Útil, pero eso aún no te dice cómo se siente tu herramienta cuando alguien está cansado a la 1 a. m. tratando de terminar un trabajo, o cuando un content manager está procesando en lote 20 artículos y a punto de renunciar.

Si quieres señales del mundo real, haz cosas como estas:

-

Incrusta feedback en el momento de uso

- Después de cada ejecución: microencuesta de 3 clics:

- “Sonó: [Demasiado robótico] [Bastante natural] [Muy humano]”

- “¿Este resultado era seguro para enviarlo tal cual? [Sí/No]”

- Luego una cajita de texto opcional y mínima: “¿Qué te molestó?”

- No preguntes “¿Qué te gustó?” Así es como consigues elogios falsos. Pregunta qué estuvo mal.

- Después de cada ejecución: microencuesta de 3 clics:

-

Mide comportamiento, no solo opiniones

- Mide:

- Con qué frecuencia los usuarios pulsan “regenerar”

- Con qué frecuencia editan el texto inmediatamente en tu editor (si tienes uno)

- Abandonos a mitad de sesión

- Si la gente regenera 3–4 veces por entrada, la herramienta te está diciendo que está fallando, aunque las encuestas se vean positivas.

- Mide:

-

Haz pruebas dirigidas con usuarios reales en vez de tráfico aleatorio

Elige grupos pequeños y específicos en lugar de “internet”:- Estudiantes que intentan evitar banderas de IA

- Redactores freelance/agencias de contenido

- Personas no nativas en inglés puliendo textos

Ofréceles: - Un espacio privado de pruebas

- Un puñado de tareas fijas (reescribir introducción de ensayo, pulir un post de LinkedIn, etc.)

- Una llamada de 10–15 minutos o sesión grabada en pantalla para cada uno

Sobórnalos con tarjetas de regalo de Amazon, uso premium gratis, lo que sea. El feedback cualitativo que obtienes de 20 personas así supera 2.000 clics anónimos.

-

Haz A/B tests de tu propia herramienta contra un baseline

En lugar de preguntar “¿Está bien?”, pregunta “¿Es mejor que X?”

Puedes ejecutar en secreto:- Versión A: salida cruda del LLM

- Versión B: tu salida humanizada

Muéstralas a ciegas a los testers y pregunta: - “¿Cuál suena más a que la escribió una persona real?”

- “¿Cuál enviarías/publicarías de verdad?”

Ni siquiera necesitas mencionar detectores aquí.

-

Usa reseñadores “hostiles” a propósito

Encuentra gente que odia el contenido de IA o son editores ultraexigentes.

Diles:- “Imagina que un redactor junior te entregó esto. Destrúyelo.”

Sus notas sobre voz, repetición, rigidez y fluidez lógica son muchísimo más poderosas que “ZeroGPT dice 0 % IA”.

- “Imagina que un redactor junior te entregó esto. Destrúyelo.”

-

Haz dogfooding en público, pero con honestidad

Usa la salida de tu Clever AI Humanizer en:- El copy de tu sitio de producto

- Notas de lanzamiento

- Posts del blog

Luego añade una pequeña línea al final:

“Esta publicación fue redactada con Clever AI Humanizer y ligeramente editada por una persona. ¿Algo se sintió raro? Cuéntanos.”

Vas a recibir feedback crudo y brutal de la gente a la que le importa lo suficiente como para quejarse. -

Prueba los “modos de fallo”, no solo el “mejor caso”

La mayoría de herramientas se ven bien con texto prolijo y formal. Deberías estar probando:- Prompts caóticos

- Inglés roto

- Jerga, emojis, formatos raros

- Cosas súper cortas como asuntos de email

Pregunta a los usuarios: - “¿Dónde falló por completo?”

Registra y clasifica esos fallos.

-

Vigila el “problema de vibra”

Incluso cuando los detectores marcan 0 % IA, mucho texto todavía “se siente” hecho por máquina: mismo ritmo, párrafos prolijos, transiciones predecibles.

No vas a detectar eso con detectores.

Sí lo captas si:- Preguntas a los usuarios: “¿Esto suena como tú?”

- Les dejas pegar “antes” y “después” y luego preguntas cuál enviarían realmente a su jefe o profesor.

-

No sobreindexes en esquivar detectores

Ligeramente en desacuerdo con el enfoque centrado en detectores de @mikeappsreviewer: los usuarios creen que quieren “0 % IA”, pero a largo plazo lo que los retiene es:- Que coincida con su tono

- Que no introduzca mentiras

- Que no los haga sonar como un bloguero genérico raro

Pon primero la UX, y en segundo lugar la “indetectabilidad”. Si no, te encadenas a un juego del gato y el ratón que al final vas a perder.

-

Añade un “medidor de calidad” brutalmente transparente para uso interno

Internamente, etiqueta cada ejecución (anonimizada) con:

- Puntuaciones de detectores

- Calificación humana (de un pequeño panel en el que confíes)

- Feedback del usuario (“notas de molestia”)

Cada mes, revisa tu peor 5–10 % de salidas. Ahí está el oro.

Si quieres un siguiente paso concreto:

- Lanza una pequeña página de “beta testers” para Clever AI Humanizer.

- Límitala, por ejemplo, a 50 usuarios reales.

- Dales un trato claro: “Úsalo gratis, pero tienes que enviar 3 ejemplos por semana de dónde falló o se sintió raro.”

No te faltan usuarios. Te falta feedback estructurado y doloroso. Construye los canales para eso y aprenderás más en dos semanas que con otras 20 capturas de pantalla de paneles de detectores.

Respuesta breve: las capturas de pantalla de detectores y las autoevaluaciones hechas con IA no son “opiniones reales de usuarios”, son un experimento de laboratorio. Vas por la mitad del camino, pero le estás preguntando al público equivocado.

Algunas ideas que no son solo repetir lo que ya dijeron @mikeappsreviewer y @kakeru:

-

Deja de preguntar si “funciona” y empieza a preguntar para quién funciona

Ahora mismo estás persiguiendo una respuesta universal: “¿Mi humanizador de IA es bueno?” Eso es vago. En la práctica hay casos de uso muy diferentes:

- Estudiantes que intentan no ser marcados por detectores

- Redactores de contenido que quieren hacer sus borradores menos robóticos

- No nativos que quieren sonar más naturales en el correo

- Marketers que quieren mantener la voz de marca

Tu problema de feedback puede ser que estás dejando entrar a todo el mundo y no escuchas a ningún grupo específico. Elige uno o dos segmentos y optimiza los bucles de feedback alrededor de ellos.

-

Ofrece presets decididos y juzga cuál es el que más se abusa

En lugar de modos genéricos como “académico simple” o “casual”, apriétalos a situaciones reales:

- “Pulido de ensayo universitario”

- “Líder de opinión en LinkedIn”

- “Correo en frío a un gerente”

- “Arreglar introducción de blog”

Luego:

- Rastrea qué preset se usa más

- Rastrea cuál tiene más “copiar todo” sin ediciones

- Rastrea cuál los usuarios abandonan a mitad del flujo

Si “Pulido de ensayo universitario” se usa muchísimo pero la gente se va después de una pasada, tienes datos de fallo específicos y accionables. Eso es mejor que otra captura de un detector.

-

Crea una comparación “Mi voz vs Voz humanizada”

Aquí discrepo un poco del foco tan fuerte en detectores: a largo plazo, a la gente le importa más la voz que el 0 % IA. Si el texto deja de sonar como ellos, abandonarán tu herramienta incluso si es “indetectable”.

Deja que los usuarios:

- Peguén el texto original

- Obtengan el resultado humanizado

- Vean un breve desglose tipo diff:

- “Formalidad: +20 %”

- “Tono personal: -30 %”

- “Longitud de oraciones: +15 %”

Luego pregunta literalmente:

“¿Esto sigue sonando como tú?” [Sí / Más o menos / No]

Solo esa pregunta te dará una señal más honesta que “Califica de 1 a 5 estrellas”.

-

Necesitas incentivos negativos, no solo sobornos

Todo el mundo habla de tarjetas regalo, perks de beta, etc. El problema: la gente dirá lo que tú quieres oír para mantener los beneficios.

Prueba esto:

- “Si nos envías 3 resultados realmente malos (capturas o texto pegado), desbloqueamos X créditos extra.”

- No estás premiando “usar mucho la herramienta”, estás premiando “encontrar dónde falla”.

Eso mantiene el foco en tus puntos débiles en lugar de comentarios vagos tipo “sí, está bien, gracias”.

-

Crea internamente un “Salón de la Vergüenza”

Ya sabes que la herramienta puede rendir bien en condiciones ideales. Lo que no tienes es un conjunto curado de:

- Peores resultados

- Frases más incómodas

- Veces en que cambió el significado

- Veces en que hizo sonar al usuario como un bloguero genérico de IA

Una vez por semana, recoge:

- Las 50 sesiones con más regeneraciones rápidas

- Las 50 con el cierre más rápido después del resultado

Inspecciona manualmente 10–20 de ellas y etiqueta por qué fueron malas. Ese patrón es la forma de mejorar.

-

Fuerza fricción en una parte del embudo

Seguramente estás optimizando para “sin login, súper rápido, fricción mínima”. Genial para tráfico, pésimo para feedback.

Considera un “sandbox Pro de feedback” separado:

- Requiere correo o registro mínimo

- Da límites más altos o modos extra

- A cambio, los usuarios:

- Marcan 2 casillas por resultado: “Natural / Robótico” y “En tema / Se desvió”

- Opcionalmente pegan contexto como “Usé esto para [escuela / trabajo / redes]”

La gente que se toma 20 segundos para registrarse tiene muchas más probabilidades de dar feedback real que visitantes aleatorios.

-

Incorpora las expectativas directamente en la interfaz

Ligero desacuerdo con la suposición implícita que quizá llevas: “Si es lo bastante bueno, los usuarios deberían poder hacer clic en copiar e irse.” No es así como la gente trata este tipo de herramientas.

Añade texto tal cual:

“Esto te llevará del 70 al 90 % del camino. Tienes que darle una rápida revisión humana antes de enviarlo.”

Luego pregunta directamente:

- “¿Tuviste que editar esto mucho?” [Un poco / Mucho / Básicamente lo reescribí]

Eso es feedback honesto que no requiere una encuesta larga.

- “¿Tuviste que editar esto mucho?” [Un poco / Mucho / Básicamente lo reescribí]

-

Aprovecha la comparación con competidores sin ser cringe

Como es obvio que la gente también está probando cosas como el humanizador de Grammarly, Ahrefs, Undetectable, etc., puedes aprovechar eso en lugar de fingir que no existen.

Añade una casilla pequeña:

- “¿Has probado herramientas similares (como los humanizadores de IA de Grammarly o Ahrefs)?

- Sí y esta es mejor

- Sí y esta es peor

- Más o menos igual

- No he probado otras”

Nada de atacar marcas, nada de “somos los mejores”. Solo datos.

Úsalos para entender el posicionamiento, no solo la calidad. - “¿Has probado herramientas similares (como los humanizadores de IA de Grammarly o Ahrefs)?

-

Deja de asumir que éxito en detectores = éxito del producto

Según lo que mostró @mikeappsreviewer, tu Clever AI Humanizer ya es sólido frente a detectores públicos. Bien. Pero pregúntate:

- “Si todos los detectores desaparecieran mañana, ¿mi herramienta seguiría valiendo la pena?”

Si la respuesta honesta es “no mucho”, entonces tu roadmap debería inclinarse hacia:

- Personalización

- Control de tono

- Seguridad (sin alucinaciones, sin afirmaciones falsas)

- Conservación de la intención original

Eso es lo que sobrevivirá cuando la carrera armamentista de detectores se enfríe.

-

Posiciona explícitamente Clever AI Humanizer como una herramienta de colaboración

Conseguirás mucho mejor feedback si dejas de fingir que es una capa de invisibilidad.

Ejemplo en tu interfaz:

“Redactado por IA, refinado por Clever AI Humanizer, terminado por ti.”

Eso prepara a los usuarios para pensar:

- “¿En qué me ayudó?”

- “¿En qué me complicó la vida?”

Pide feedback con ese marco:

- “¿Clever AI Humanizer te ahorró tiempo en esto?” [Sí / No]

- “¿Cambió tu significado?” [Sí / No]

La intersección de “No me ahorró tiempo” + “Cambió mi significado” es donde más estás fallando.

Si quieres una acción muy práctica que puedes implementar en un día:

- Después de cada resultado, muestra 3 botones:

- “Lo enviaría tal cual”

- “Lo usaría pero necesito editar”

- “Esto no es usable”

- Si eligen el último, haz una sola pregunta adicional:

- “Demasiado robótico / Fuera de tema / Tono incorrecto / Inglés mal construido / Otro”

Ese mini flujo, a gran escala, te dirá más sobre el rendimiento real de Clever AI Humanizer en el mundo real que otro mes de pruebas con detectores o de preguntar a otros LLMs si se “dejan engañar”.

Análisis rápido desde otro ángulo, ya que otros ya profundizaron en UX y pruebas:

1. Trata la “retroalimentación real” como datos, no como opiniones

En lugar de más experimentos con detectores, conecta métricas duras alrededor de Clever AI Humanizer:

Números clave a seguir:

- Tasa de finalización: texto pegado → humanizar → copiar.

- Tasa de regeneración por entrada: muchas regeneraciones = insatisfacción.

- Tiempo hasta copiar: si la gente copia en 2–5 segundos, no está leyendo, está farmeando.

- Intención de edición: clic en “Copiar con formato” vs “Copiar texto plano” vs “Descargar”. Patrones distintos suelen corresponder a casos de uso distintos.

Eso te da retroalimentación silenciosa de cada sesión, no solo del puñado de personas dispuestas a escribirte párrafos.

2. Etiquetado ligero de cohortes

Otros sugirieron segmentar por persona. Yo lo haría brutalmente simple:

En el primer uso, un selector de 1 clic encima de la caja:

- “Usando esto para: Escuela / Trabajo / Social / Otro”

Sin inicio de sesión, sin fricción. Solo guarda una etiqueta de cohorte anónima.

Ahora puedes ver:

- Escuela: mayor regeneración y abandono

- Trabajo: más tiempo en la página pero alta tasa de copiado

- Social: copia rápida, poca longitud, quizá no vale la pena optimizar

Ya no estás adivinando con qué audiencia estás fallando.

3. Prueba A/B de humanización “agresiva vs conservadora”

Ahora mismo Clever AI Humanizer parece optimizado para evadir detectores y mantener legibilidad. Eso está bien, pero usuarios distintos quieren niveles distintos de edición.

Haz una prueba silenciosa:

- Versión A: cambios mínimos, preserva estructura, paráfrasis ligera

- Versión B: reescritura más intensa, más variación, más cambios de ritmo

Luego compara:

- Qué versión genera más comportamiento de “copiar y salir”

- Qué versión dispara más el uso de “Volver a ejecutar”

Sin encuestas, sin rogar por opiniones. El comportamiento es la respuesta.

4. Pros / contras como control de realidad del producto

Comparado con lo que describieron @kakeru y @andarilhonoturno, creo que tu herramienta ya está en el grupo de “mejor que la media”, pero ayuda ponerle nombre a las cosas:

Pros de Clever AI Humanizer

- Muy buen desempeño frente a detectores de IA comunes cuando se prueba en contenido realista.

- El resultado generalmente se lee limpio y gramatical sin el truco forzado de “spam de errores tipográficos” que usan algunas herramientas.

- Varios estilos (Académico sencillo, Casual, etc.) que encajan bastante bien con situaciones de escritura reales.

- Redactor de IA integrado que puede generar y humanizar en una sola pasada, lo que reduce huellas obvias de LLM.

- Onboarding gratuito y liviano, ideal para adopción temprana y para canalizar muchos datos de prueba.

Contras de Clever AI Humanizer

- El control del conteo de palabras es laxo, lo cual es un problema real para tareas y briefs estrictos.

- A veces reescribe demasiado agresivo, introduciendo desvíos de contenido que el usuario no siempre nota.

- Incluso con puntuaciones de 0% IA, algunos textos siguen “sonando” a máquina en estructura y ritmo.

- Una propuesta de valor centrada en detectores te mete en un juego constante del gato y el ratón y puede envejecer mal.

- Poca personalización explícita de voz, así que los usuarios frecuentes pueden sentir que su escritura empieza a sonar igual.

5. Deja de sobreajustar a detectores, empieza a sobreajustar a usuarios recurrentes

Aquí es donde discrepo un poco con el foco fuerte en detectores que se ve en las pruebas de @mikeappsreviewer. Las capturas de detectores sirven para marketing, pero son una meta de producto frágil.

Señales más duraderas:

- Cuántos usuarios vuelven en 7 días

- Entre los usuarios que regresan, cuántas sesiones crecen en número de palabras con el tiempo (señal de confianza)

- Cada cuánto el mismo navegador / IP usa la herramienta en contextos distintos (escuela + trabajo, etc.)

Los usuarios reales no se quedan porque un detector diga “0% IA”. Se quedan porque:

- Les ahorró tiempo.

- No los dejó en ridículo.

- No cambió lo que querían decir.

Optimiza primero para comportamiento repetido, y después para las puntuaciones de detectores.

6. Construye un “patrón de confianza” en lugar de un “patrón de camuflaje”

No deberías intentar vencer a todos los detectores futuros. Deberías intentar ser la herramienta que:

- Mantiene la semántica intacta.

- Permite ajustar el tono.

- Documenta claramente sus limitaciones.

Un añadido sutil en la interfaz que rinde frutos:

- Después de generar el resultado, muestra un breve resumen honesto como:

- “Conservación del significado: alta”

- “Cambio de tono: moderado”

- “Cambio en estructura de frases: alto”

La gente empieza a confiar en ti porque muestras tu trabajo. Esa confianza, indirectamente, te da mejor retroalimentación que cualquier encuesta.

7. Cómo obtener retroalimentación cualitativa sin molestar

Toma prestados disparadores basados en comportamiento:

-

Si el usuario ejecuta 3+ regeneraciones sobre la misma entrada:

- Muestra un pequeño aviso en línea:

- “¿No obtienes lo que necesitas? Cuéntanos en 5 palabras.” [cuadro de texto pequeño]

Eso produce comentarios brutalmente honestos como “demasiado robótico”, “cambió mi idea”, “demasiado extenso”.

- “¿No obtienes lo que necesitas? Cuéntanos en 5 palabras.” [cuadro de texto pequeño]

- Muestra un pequeño aviso en línea:

-

Si el usuario pasa >40 segundos editando texto en tu caja antes de humanizar:

- Pregunta: “¿Estás corrigiendo texto de IA o puliendo tu propia escritura?”

Eso te ayuda a entender si Clever AI Humanizer se percibe como “reparador de IA” o “editor”, lo que importa para la hoja de ruta.

- Pregunta: “¿Estás corrigiendo texto de IA o puliendo tu propia escritura?”

Sin modales gigantes, sin “califícanos con 5 estrellas”, solo pequeños empujones contextuales.

8. Dónde encajan los competidores en tu modelo mental

Ya tienes buenas comparaciones de gente como @kakeru y la reseña más centrada en detectores de @mikeappsreviewer. Úsalas como referencias, pero no como estrellas guía.

Trátalos como:

- “Esto es lo que pasa cuando maximizas evasión de detectores e ignoras la voz.”

- “Esto es lo que pasa cuando haces paráfrasis ligera y te mantienes seguro pero detectable.”

La ventaja de Clever AI Humanizer está en intentar equilibrar legibilidad y detección. Tu próxima ventaja debería ser personalización y control, no solo porcentajes más bajos en otro detector público más.

Si quieres una cosa concreta para lanzar esta semana que mejore el producto y te dé señales del mundo real:

- Añade dos interruptores antes de humanizar:

- “Conservar la estructura lo máximo posible”

- “Cambiar la estructura para más variación humana”

Luego registra qué combinación de interruptores se correlaciona con:

- Mayores tasas de copiado

- Menos regeneraciones

- Más sesiones de usuarios que regresan

Sabrás muy rápido qué tipo de “humanización” es la que tus usuarios realmente quieren, en lugar de adivinar a partir de gráficas de detectores.