J’ai créé un outil intelligent de « humanisation » d’IA censé rendre les textes générés par IA plus naturels et authentiques, mais j’ai du mal à obtenir des retours honnêtes de vrais utilisateurs. J’aimerais savoir comment il se comporte dans des usages réels : est-ce que le texte semble vraiment humain, est-il fiable pour la rédaction de contenu et le SEO, et où est-ce qu’il échoue ou paraît clairement généré par IA ? J’ai besoin de retours détaillés et concrets pour pouvoir corriger les problèmes, améliorer la qualité, et m’assurer qu’il est sûr et fiable pour les blogueurs, les marketeurs et les utilisateurs ordinaires qui veulent du contenu IA au ton humain.

Clever AI Humanizer : mon expérience réelle, preuves à l’appui

Je me suis amusé récemment avec tout un tas d’outils de « humanisation d’IA », principalement parce que je voyais sans arrêt des gens sur Discord et Reddit demander lesquels fonctionnent encore. Beaucoup se sont soit cassés, soit transformés en SaaS payants du jour au lendemain, soit ont juste discrètement empiré.

Du coup, j’ai décidé de ne partir qu’avec des outils vraiment gratuits, sans compte, sans carte bancaire. Premier sur la liste : Clever AI Humanizer.

Vous pouvez le trouver ici :

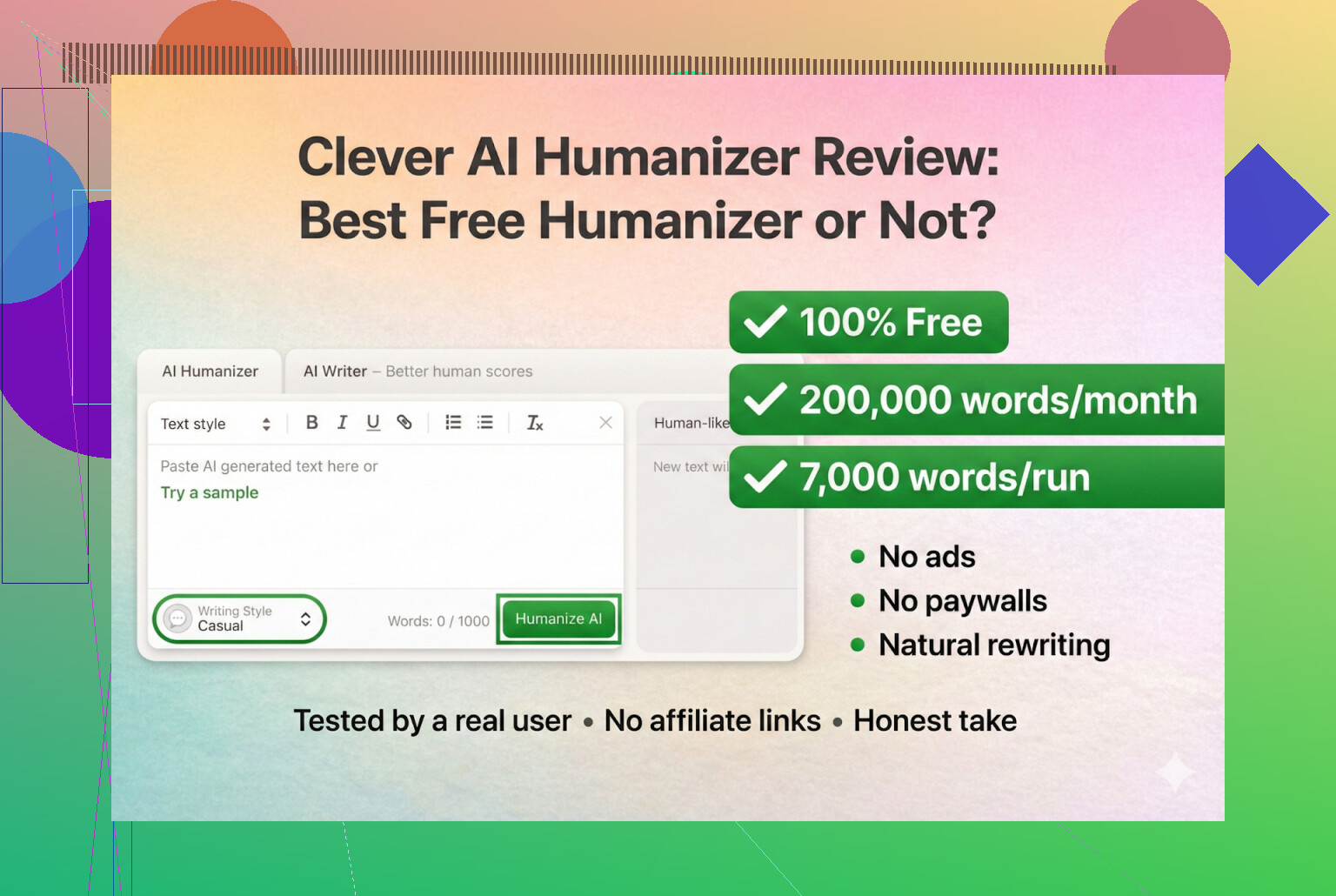

Clever AI Humanizer — Meilleur humaniseur 100 % gratuit

Autant que je puisse en juger, c’est le vrai, pas un clone, pas un rebrand bizarre.

La confusion sur l’URL et les copies factices

Petit message de service, parce que je me suis déjà fait avoir : il existe un tas de sites « AI humanizer » avec des noms similaires qui achètent des pubs sur les mêmes mots-clés. Plusieurs personnes m’ont MP pour me demander « lequel est le vrai Clever AI Humanizer ? » parce qu’elles étaient tombées sur un site complètement différent qui essayait de leur faire payer des fonctions « pro ».

Pour clarifier :

- Clever AI Humanizer lui‑même (Clever AI Humanizer — Meilleur humaniseur 100 % gratuit)

- D’après ce que j’ai vu :

- Pas de formules premium

- Pas d’abonnements

- Pas de popups « débloquez 5 000 mots de plus pour 9,99 $ »

Si vous avez cliqué sur une annonce Google et que votre carte bleue s’est mise à chauffer, ce n’était pas cet outil.

Comment je l’ai testé (100 % IA contre IA)

Je voulais voir jusqu’où il pouvait aller dans un scénario vraiment extrême, donc je ne l’ai pas ménagé.

- J’ai demandé à ChatGPT 5.2 d’écrire un article 100 % IA sur Clever AI Humanizer.

- Aucune retouche humaine.

- Copié‑collé brut.

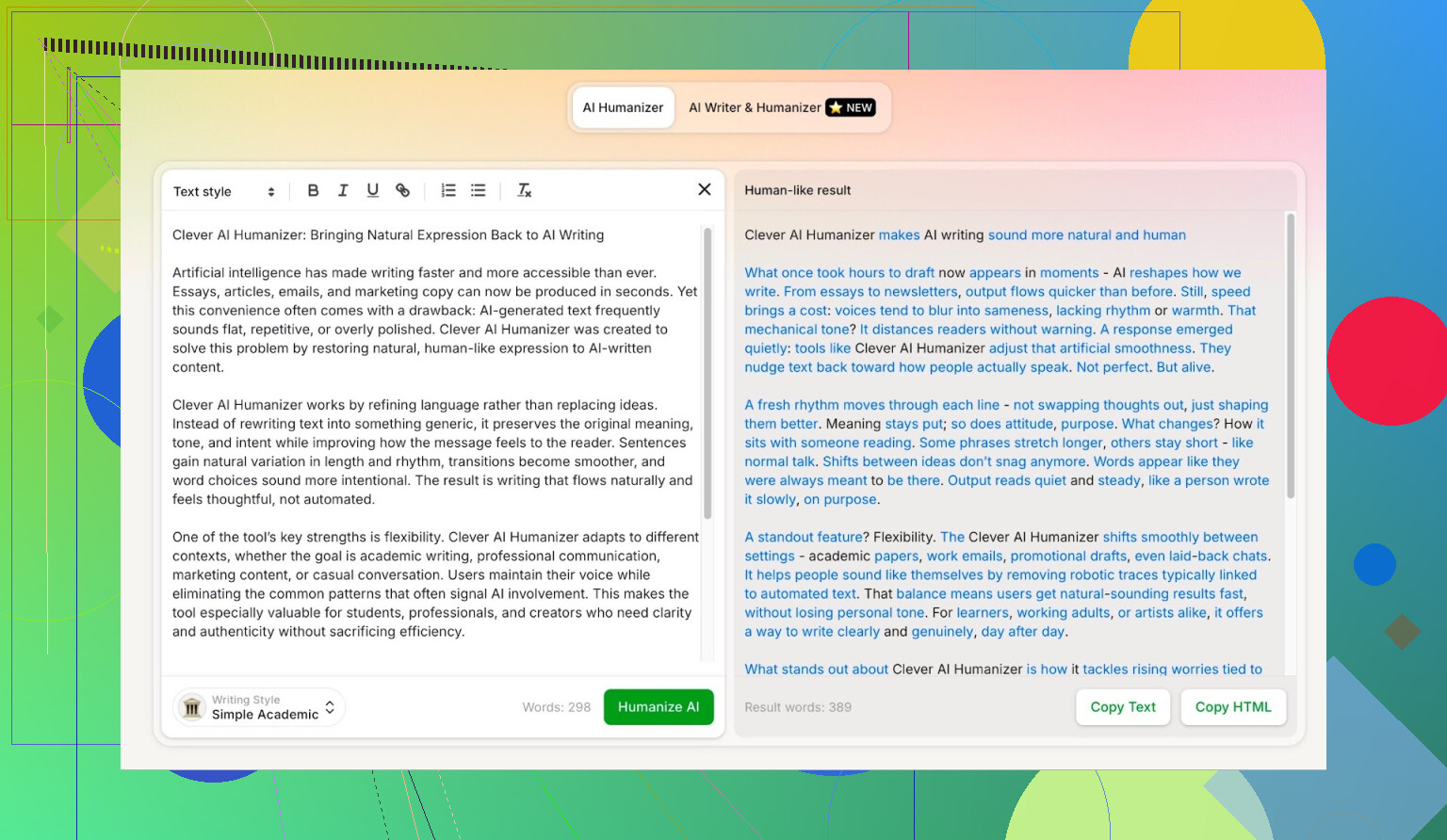

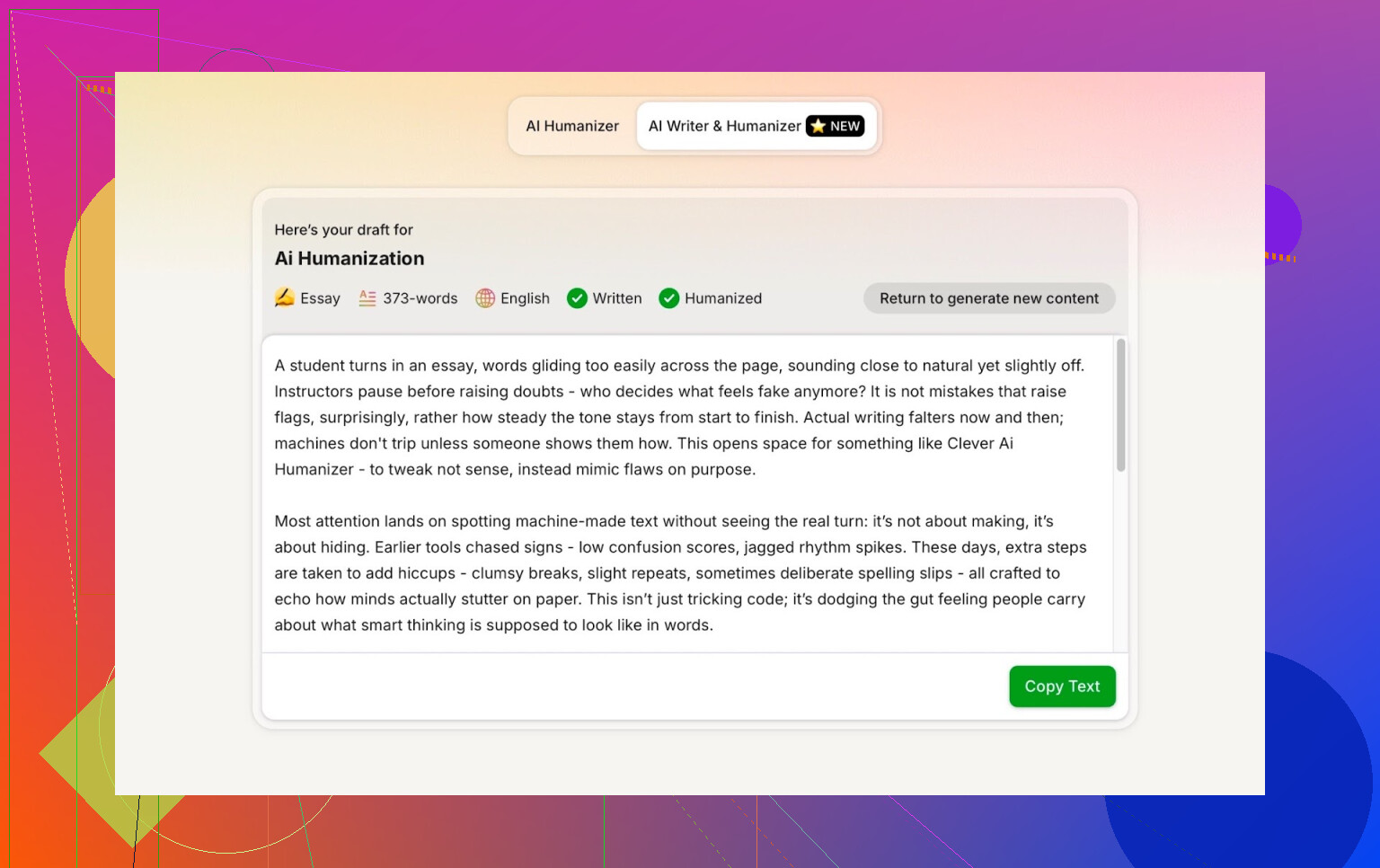

- J’ai pris ce texte et je l’ai passé dans Clever AI Humanizer en mode Simple Academic.

- J’ai soumis le résultat à plusieurs détecteurs d’IA.

- Puis j’ai demandé à ChatGPT 5.2 lui‑même de juger le texte réécrit.

Comme ça, pas d’excuse du genre « peut‑être que le texte de base faisait déjà assez humain ». C’est 100 % machine à machine.

Mode Simple Academic : pourquoi j’ai choisi l’option la plus dure

Je n’ai pas pris le style Décontracté ou Blog ou quoi que ce soit de léger. Je suis allé directement sur Simple Academic.

Ce que ce mode donne en pratique :

- Toujours lisible, sans jargon de revue scientifique

- Un peu formel, structuré et propre

- Assez de tournures « académiques » pour sonner sérieux, sans ressembler à une thèse

C’est exactement dans ce créneau que les détecteurs d’IA hurlent souvent « IA ! », parce que les phrases deviennent trop nettes et équilibrées. Donc si un humanizer arrive à produire ce style tout en obtenant de bons scores, c’est notable.

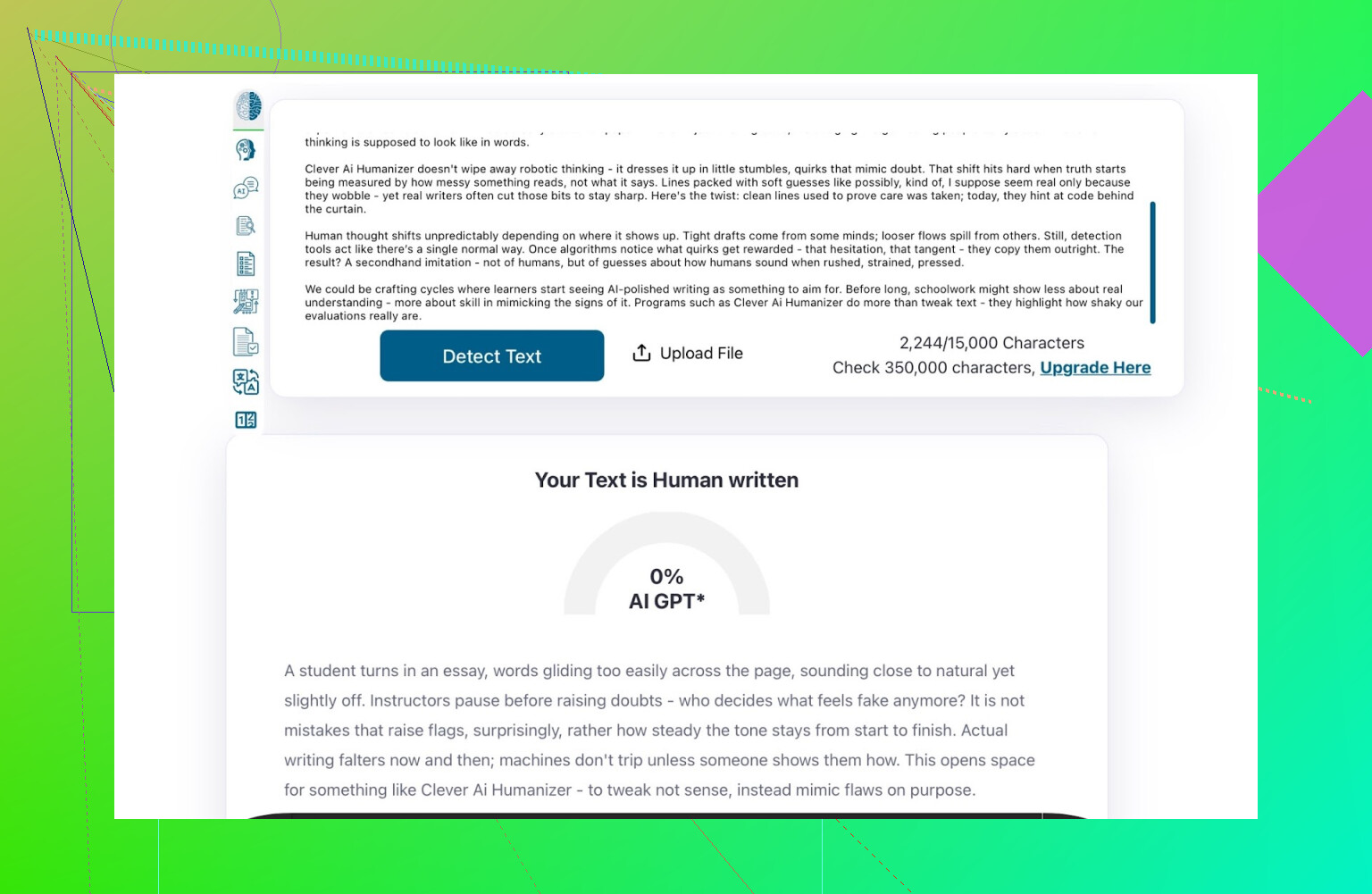

ZeroGPT : le test « je ne lui fais pas confiance, mais tout le monde l’utilise »

Je ne suis pas fan de ZeroGPT pour une raison principale : il classe la Constitution américaine comme « 100 % IA ».

Une fois que vous avez vu ça, la confiance chute vite.

Cela dit :

- Il est partout sur Google.

- Les gens continuent de l’utiliser parce qu’il sort en premier.

- Donc je l’ai inclus.

Résultat pour le texte passé dans Clever AI Humanizer :

ZeroGPT : 0 % d’IA détectée.

Pour ce que ça vaut, c’est à peu près le meilleur score que cet outil puisse donner.

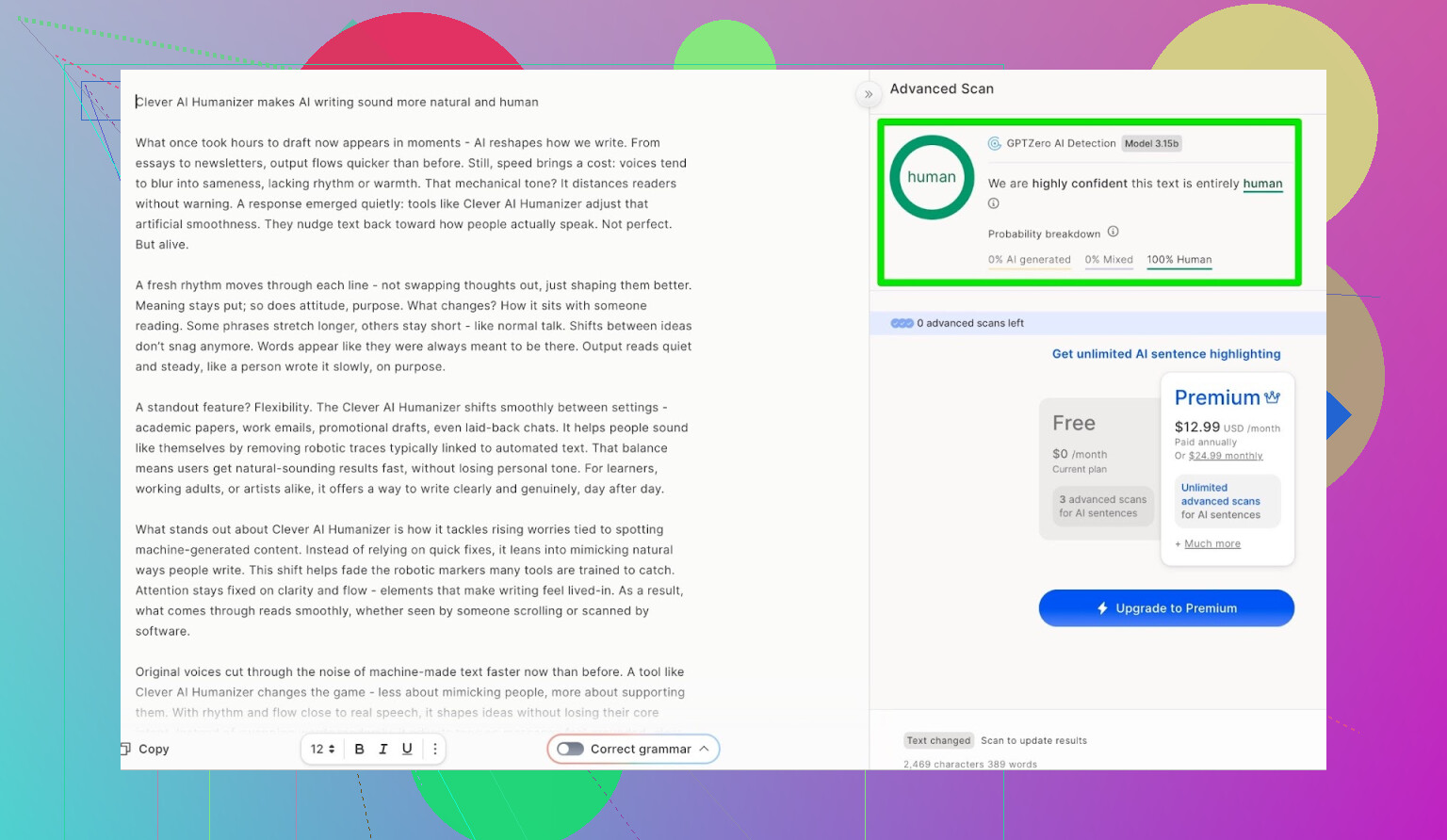

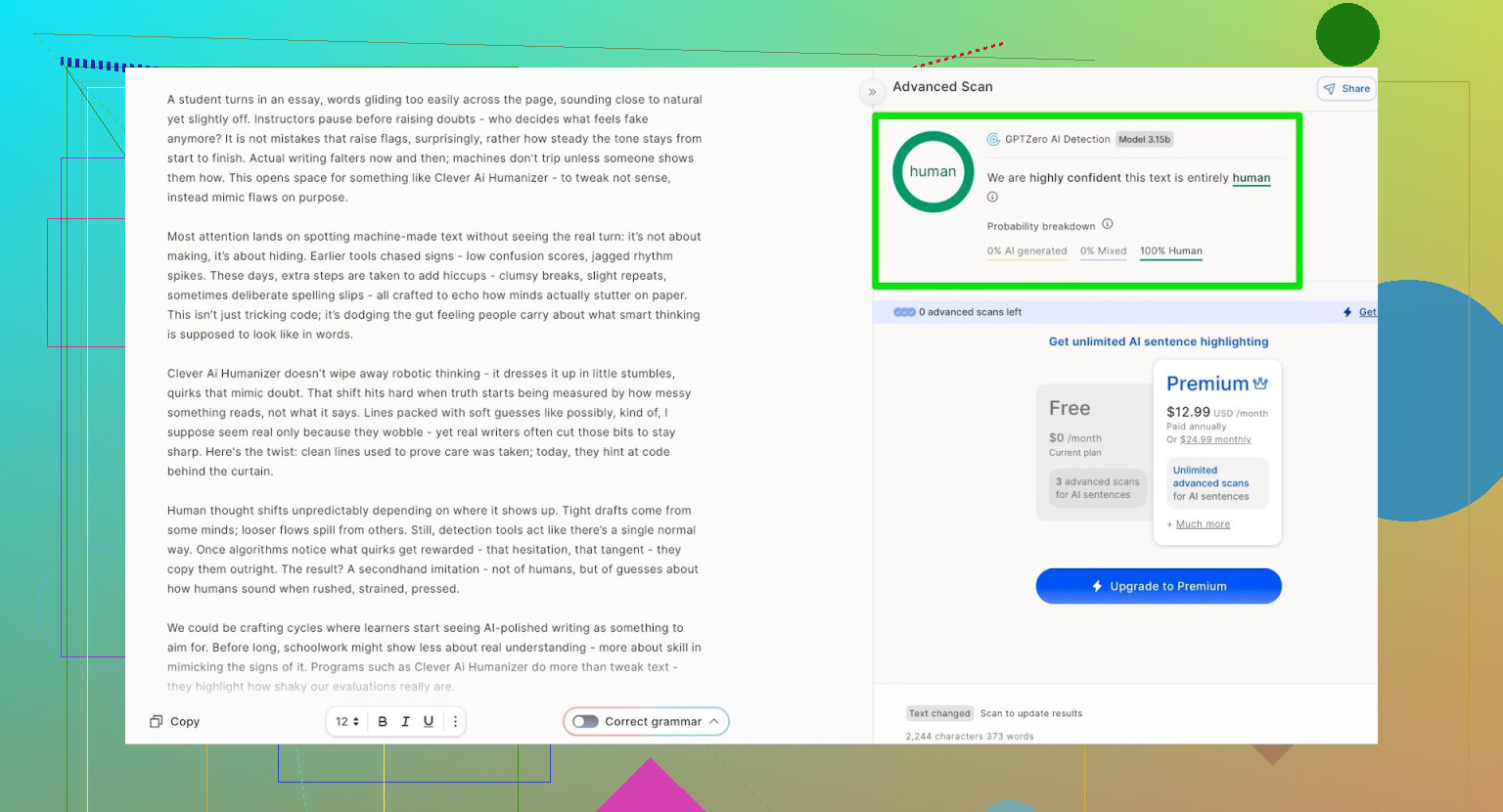

GPTZero : deuxième avis, même constat

Ensuite, j’ai testé GPTZero.

Celui‑là est largement utilisé dans les écoles et les universités, donc c’est souvent celui que les gens craignent le plus.

Le texte sorti de Clever AI Humanizer (mode Simple Academic) est revenu comme :

- 100 % rédigé par un humain

- 0 % IA

Sur les deux détecteurs publics les plus connus, le texte est donc passé avec des scores parfaits.

Mais est‑ce que ça se lit comme un truc pourri ?

C’est là que beaucoup d’humanizers se plantent :

Ils passent les détecteurs, mais on a l’impression que le texte a été traduit 4 fois dans des sens différents.

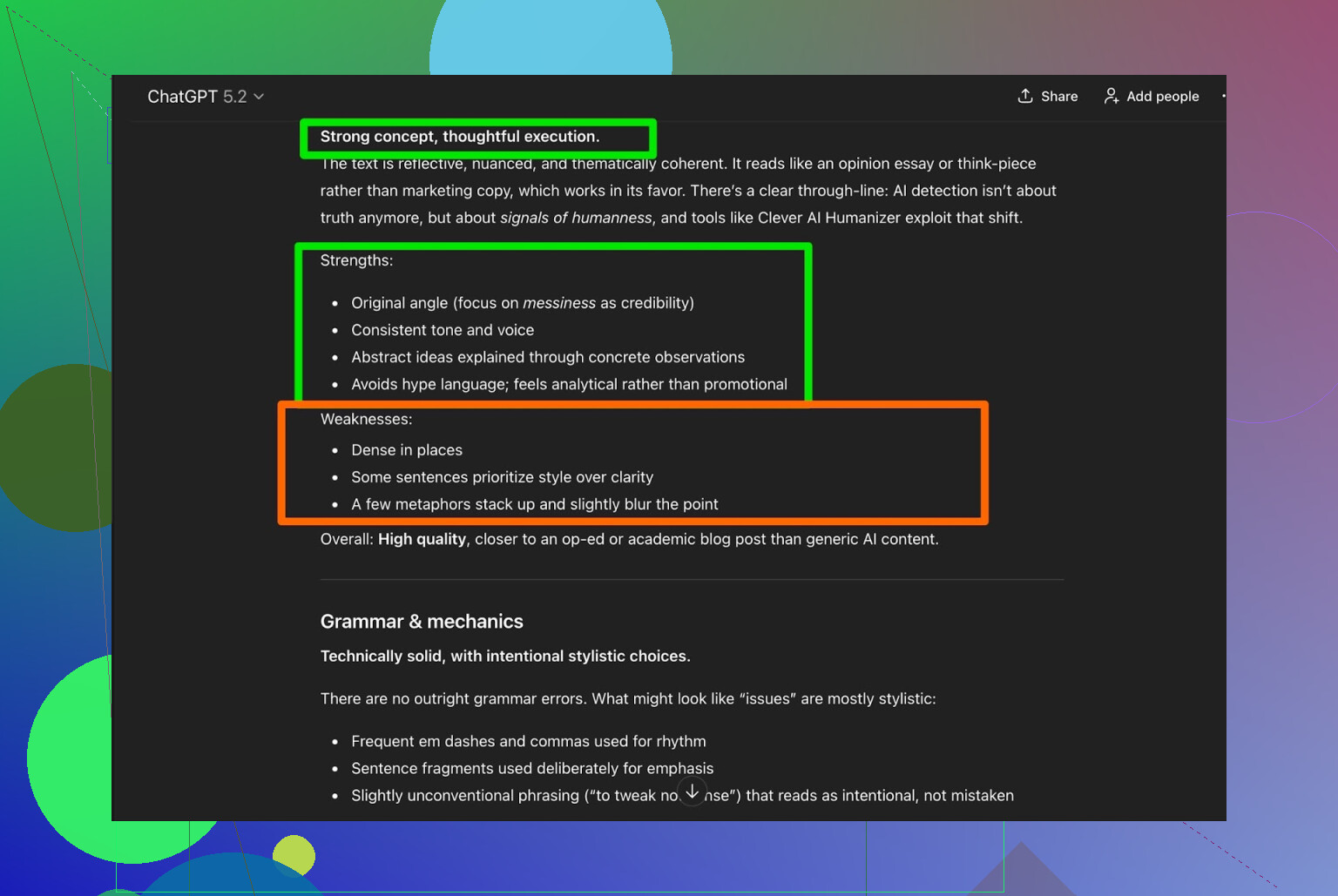

J’ai pris la sortie de Clever AI Humanizer et j’ai demandé à ChatGPT 5.2 de l’analyser :

Verdict général :

- Grammaire : solide

- Style : colle plutôt bien au Simple Academic

- Recommandation : indique quand même qu’une relecture humaine est recommandée

Honnêtement, je suis d’accord. C’est juste la réalité :

Tout texte rédigé ou humanisé par une IA gagne à être relu par un humain.

Si un outil prétend « aucune relecture humaine nécessaire », c’est probablement du marketing, pas la vérité.

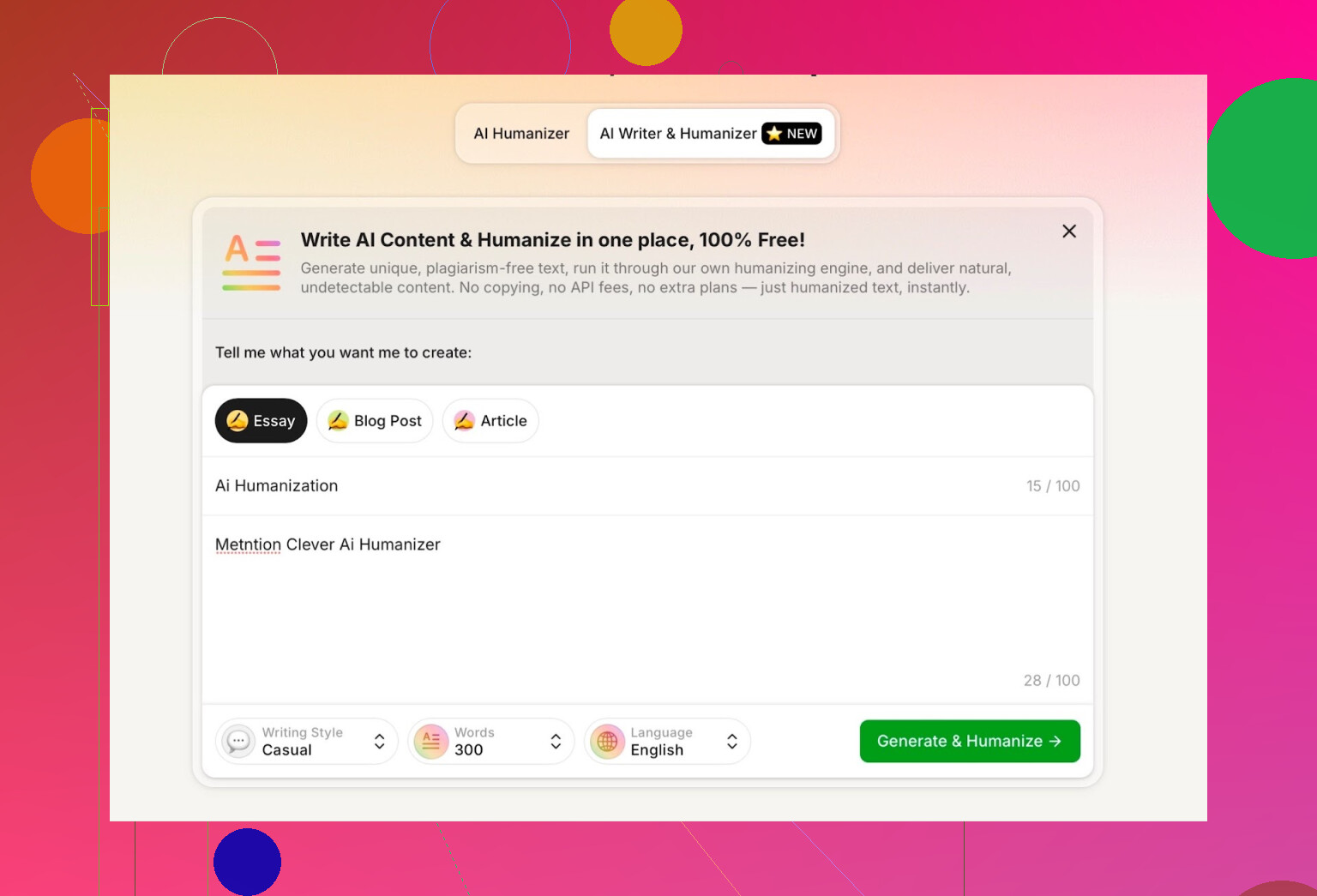

Test du rédacteur IA intégré à Clever AI Humanizer

Ils ont un autre outil ici :

https://aihumanizer.net/frai-writer

C’est là que ça devient plus intéressant. Au lieu de :

LLM → Copier → Coller dans un humanizer → Croiser les doigts

On peut :

- Générer et humaniser en une seule étape

- Laisser leur système contrôler la structure et le style dès le départ

C’est important parce que si l’outil génère lui‑même le contenu, il peut le façonner de manière à éviter naturellement certains schémas ultra typiques de l’IA.

Pour le test, j’ai :

- Choisi le style Casual

- Sujet : humanisation d’IA, en mentionnant Clever AI Humanizer

- Volontairement glissé une petite erreur dans le prompt pour voir comment il la gérait

La sortie était propre, conversationnelle, et n’a pas reproduit mon erreur de façon bizarre.

Un point que je n’ai pas aimé :

- J’ai demandé 300 mots

- Il m’en a donné plus de 300

Si je dis 300, je veux 300, pas 412. Ce genre de détail compte quand on a des limites strictes (devoirs, briefs de contenu, etc.).

C’est ma première vraie critique.

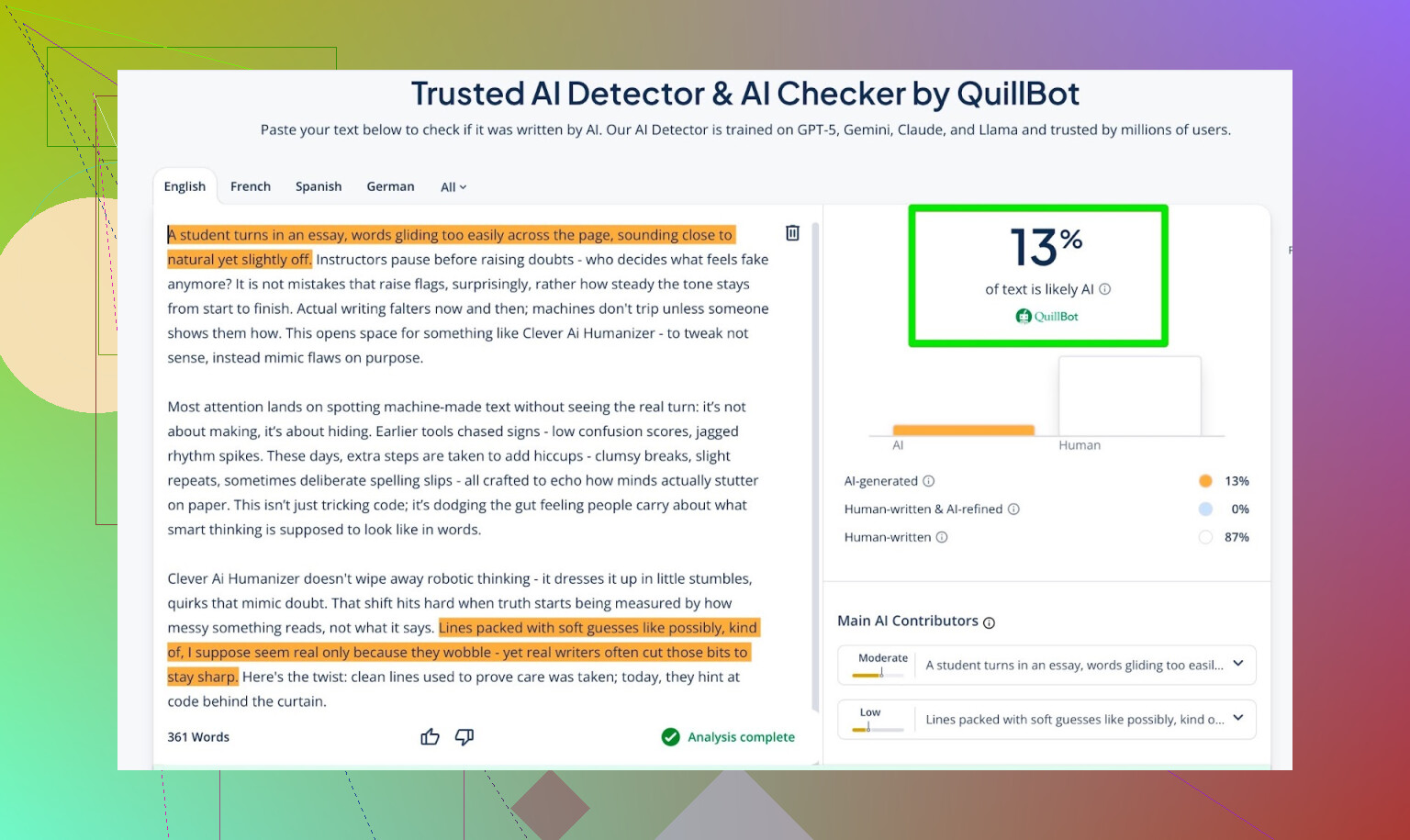

Scores de détection pour la sortie du rédacteur IA

J’ai pris ce que le rédacteur IA avait produit et je l’ai soumis à :

- GPTZero

- ZeroGPT

- QuillBot detector pour un point de comparaison supplémentaire

Résultats :

- GPTZero : 0 % IA

- ZeroGPT : 0 % IA, 100 % humain

- QuillBot : 13 % IA

Donc QuillBot a détecté un léger côté « IA », mais majoritairement humain.

Globalement, c’est plutôt bon.

Demander à ChatGPT 5.2 de juger la sortie du rédacteur IA

Voilà la partie qui m’intéressait vraiment : pas seulement « est‑ce que ça trompe les détecteurs », mais :

- Est‑ce que ça sonne comme une personne ?

- Est‑ce que le ton reste cohérent ?

- Est‑ce que ça se lit naturellement ?

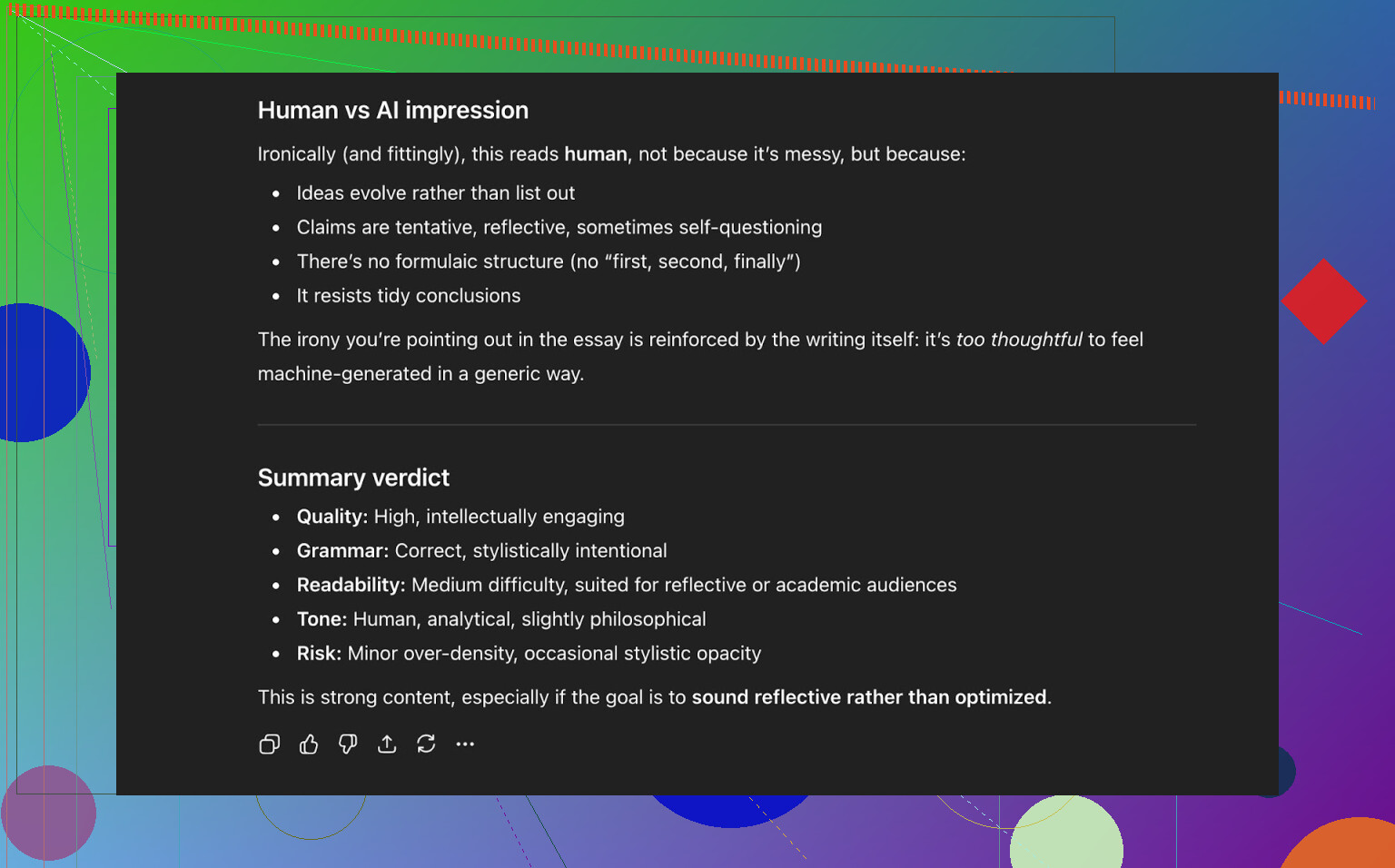

J’ai renvoyé le texte du rédacteur IA dans ChatGPT 5.2 et demandé s’il lui paraissait humain ou généré par IA.

Conclusion de ChatGPT 5.2 :

- Se lit comme un texte écrit par un humain

- Qualité élevée

- Rien de clairement cassé dans la grammaire ou la structure

À ce stade, le texte :

- Passe trois détecteurs publics sans problème

- « Trompe » aussi un LLM moderne qui le classe comme texte humain

Comment il se compare aux autres humanizers que j’ai testés

Dans mes propres tests, Clever AI Humanizer a fait mieux qu’un paquet d’outils souvent cités.

Voici un résumé rapide issu de ces essais :

| Outil | Gratuit | Score du détecteur d’IA |

| ⭐ Clever AI Humanizer | Oui | 6 % |

| Grammarly AI Humanizer | Oui | 88 % |

| UnAIMyText | Oui | 84 % |

| Ahrefs AI Humanizer | Oui | 90 % |

| Humanizer AI Pro | Limité | 79 % |

| Walter Writes AI | Non | 18 % |

| StealthGPT | Non | 14 % |

| Undetectable AI | Non | 11 % |

| WriteHuman AI | Non | 16 % |

| BypassGPT | Limité | 22 % |

Outils qu’il a surpassés dans mes tests réels :

- Grammarly AI Humanizer

- UnAIMyText

- Ahrefs AI Humanizer

- Humanizer AI Pro

- Walter Writes AI

- StealthGPT

- Undetectable AI

- WriteHuman AI

- BypassGPT

Pour être clair : ce tableau est basé sur les scores des détecteurs, pas sur « lequel sonne le mieux subjectivement ».

Là où Clever AI Humanizer reste perfectible

Ce n’est ni magique ni parfait.

Quelques points que j’ai remarqués :

- Contrôle du nombre de mots approximatif

- Demandez 300 mots, vous en aurez parfois 280, parfois 370.

- Des schémas peuvent encore apparaître

- Certains LLM peuvent parfois repérer des passages au style un peu trop IA.

- Dérive de contenu

- Il ne colle pas toujours au texte original ; parfois il réécrit plus fort que prévu.

Côté positif :

- Qualité grammaticale : autour de 8–9/10 dans mes tests

- Le texte se lit assez bien, sans buter sur une tournure toutes les deux lignes

- Pas de stratégie du « faux bug volontaire » du style écrire « i was » au lieu de « I was » juste pour tromper les détecteurs

Ce dernier point compte. Certains outils injectent exprès des erreurs pour paraître plus humains. Ça passe peut‑être mieux auprès des détecteurs, mais ça dégrade le texte.

Le truc étrange : 0 % IA ne veut pas toujours dire « vraiment humain »

Il y a quelque chose de subtil et difficile à décrire : même quand un texte obtient 0 % IA sur plusieurs outils, on peut parfois sentir qu’il est façonné par une machine. Le rythme, la façon d’introduire les idées, la propreté générale.

Clever AI Humanizer s’en sort mieux que la plupart, mais ce fond de « pattern IA » est encore là parfois. Ce n’est pas vraiment un reproche ciblé sur l’outil ; c’est plutôt l’état actuel de tout l’écosystème.

C’est littéralement un jeu du chat et de la souris :

- Les détecteurs s’améliorent

- Les humanizers s’adaptent

- Les détecteurs se mettent à jour

- Et ça recommence

Si vous attendez d’un outil qu’il soit « à l’épreuve du futur », vous serez déçu.

Alors, est‑ce « le meilleur » humanizer gratuit en ce moment ?

Pour les outils gratuits que j’ai réellement testés avec des détecteurs et des LLM :

- Je placerais Clever AI Humanizer en tête pour l’instant.

- Surtout si l’on prend en compte qu’il propose :

- Un humanizer pour du texte déjà écrit

- Un rédacteur IA intégré qui humanise en écrivant

Vous devez quand même :

- Lire vous‑même la sortie

- Corriger ce qui cloche

- Ajuster le ton pour que ça ressemble à vous

Mais si votre question est :

« Est‑ce que Clever AI Humanizer vaut le coup d’être essayé maintenant, surtout gratuitement ? »

D’après mes tests : oui.

Bonus si vous voulez creuser le sujet

Il existe quelques discussions et tests sur Reddit avec plus de captures et de preuves :

-

Comparatif global des meilleurs humanizers avec résultats de détection :

https://www.reddit.com/r/DataRecoveryHelp/comments/1oqwdib/best_ai_humanizer/?tl=fr -

Un fil de review spécifique à Clever AI Humanizer :

https://www.reddit.com/r/DataRecoveryHelp/comments/1ptugsf/clever_ai_humanizer_review/?tl=fr

Si vous décidez d’essayer Clever AI Humanizer, je le traiterais quand même comme :

- Un assistant, pas un remplaçant

- Un outil qui vous amène à 70–90 % du résultat

- Un système qui n’est aussi bon que la personne qui relit le texte final

Au bout du compte, c’est toujours vous qui devez assumer les mots.

Réponse courte : tu n’obtiendras pas le genre de retour honnête de vrais utilisateurs que tu veux simplement en regardant des scores de détecteurs ou en demandant à d’autres IA ce qu’elles en pensent. Ça fait partie de l’histoire, mais c’est aussi la partie la plus paresseuse.

Tu as déjà vu @mikeappsreviewer faire les Jeux olympiques des détecteurs et des tests structurés. Utile, mais ça ne te dit toujours pas ce que ressent quelqu’un à 1 h du matin, crevé, qui essaie de finir un devoir, ou un content manager qui traite 20 articles à la chaîne et est à deux doigts de démissionner.

Si tu veux un signal du monde réel, fais des choses comme ça :

-

Intégrer le feedback au moment de l’usage

- Après chaque exécution : micro-sondage en 3 clics :

- « Le ton semblait : [Trop robotique] [Assez naturel] [Très humain] »

- « Est-ce que ce résultat est sûr à envoyer tel quel ? [Oui/Non] »

- Puis une petite zone de texte facultative : « Qu’est-ce qui t’a agacé ? »

- Ne demande pas « Qu’est-ce que tu as aimé ? ». C’est comme ça qu’on obtient des compliments bidons. Demande ce qui était nul.

- Après chaque exécution : micro-sondage en 3 clics :

-

Suivre les comportements, pas seulement les opinions

- Mesure :

- À quelle fréquence les utilisateurs cliquent sur « régénérer »

- À quelle fréquence ils éditent immédiatement le texte dans ton éditeur (si tu en as un)

- Les abandons en plein milieu de session

- Si les gens régénèrent 3 à 4 fois pour une entrée, l’outil est en train de te dire qu’il échoue, même si les sondages ont l’air positifs.

- Mesure :

-

Faire des tests ciblés avec de vrais utilisateurs, pas du trafic aléatoire

Prends de petits groupes spécifiques plutôt que « tout internet » :- Étudiants qui essaient d’éviter les flags IA

- Rédacteurs freelances/agences de contenu

- Personnes non natives en anglais qui peaufinent leurs textes

Propose-leur : - Un espace de test privé

- Une poignée de tâches fixes (réécrire une intro de dissertation, peaufiner un post LinkedIn, etc.)

- Un appel de 10–15 minutes ou une session enregistrée écran pour chacun

Soudoye avec des cartes cadeaux Amazon, de l’accès premium gratuit, peu importe. Le feedback qualitatif de 20 personnes comme ça vaut mieux que 2 000 clics anonymes.

-

Faire du A/B test de ton propre outil contre un standard

Au lieu de demander « Est-ce que c’est bon ? », demande « Est-ce que c’est mieux que X ? »

Tu peux faire tourner en douce :- Version A : sortie brute du LLM

- Version B : ta sortie humanisée

Montre-les en aveugle aux testeurs et demande : - « Lequel semble le plus écrit par un vrai humain ? »

- « Lequel est-ce que tu soumettrais/posterais vraiment ? »

Tu n’as même pas besoin de parler de détecteurs ici.

-

Utiliser volontairement des testeurs “hostiles”

Trouve des gens qui détestent le contenu IA ou des éditeurs ultra-pointilleux.

Dis-leur :- « Fais comme si un junior t’avait rendu ce texte. Détruis-le. »

Leurs remarques sur la voix, les répétitions, la rigidité et la logique sont bien plus utiles que « ZeroGPT indique 0 % IA ».

- « Fais comme si un junior t’avait rendu ce texte. Détruis-le. »

-

L’utiliser toi-même en public, mais honnêtement

Utilise la sortie de ton Clever AI Humanizer sur :- Le texte de ton site produit

- Les notes de version

- Les articles de blog

Puis ajoute une petite ligne en bas :

« Cet article a été rédigé avec Clever AI Humanizer puis légèrement édité par un humain. Quelque chose t’a paru bizarre ? Dis-le-nous. »

Tu recevras des retours bruts et directs de la part de ceux qui tiennent assez à ton produit pour se plaindre. -

Tester les modes d’échec, pas seulement les cas idéaux

La plupart des outils ont l’air corrects sur du texte propre et formel. Tu devrais tester :- Des prompts chaotiques

- De l’anglais cassé

- Du slang, des emojis, des formats bizarres

- Des choses très courtes comme des objets d’email

Demande aux utilisateurs : - « Où est-ce que ça s’est complètement planté ? »

Enregistre et catégorise ces échecs.

-

Surveiller le “problème de vibes”

Même quand les détecteurs affichent 0 % IA, beaucoup de textes ont encore une “forme” de machine : même rythme, paragraphes bien rangés, transitions prévisibles.

Tu ne verras pas ça avec des détecteurs.

Tu le verras si tu :- Demandes aux utilisateurs : « Est-ce que ça sonne comme toi ? »

- Les laisses coller un “avant” et “après”, puis leur demandes lequel ils enverraient vraiment à leur boss ou prof.

-

Ne pas tout miser sur le contournement des détecteurs

Légère divergence avec l’angle très centré détecteurs de @mikeappsreviewer : les utilisateurs pensent qu’ils veulent « 0 % IA », mais à long terme ce qui les retient, c’est :- Ça correspond à leur ton

- Ça n’invente pas de mensonges

- Ça ne les fait pas sonner comme un blogueur générique bizarre

Mets l’UX en premier, l’“indétectabilité” en second. Sinon tu restes enfermé dans un jeu du chat et de la souris que tu finiras par perdre.

-

Te donner un “compteur de qualité” interne, brutalement honnête

En interne, étiquette chaque exécution (anonymisée) avec :

- Les scores des détecteurs

- Une note humaine (d’un petit panel de confiance)

- Le feedback utilisateur (« notes d’agacement »)

Chaque mois, passe en revue tes 5–10 % pires sorties. C’est là que se trouve l’or.

Si tu veux une prochaine étape concrète :

- Crée une petite page « bêta testeur » sur Clever AI Humanizer.

- Limite-la, disons, à 50 vrais utilisateurs.

- Propose un deal clair : « Utilise-le gratuitement, mais tu dois envoyer 3 exemples par semaine où ça a été nul ou bizarre. »

Tu n’es pas vraiment à court d’utilisateurs. Tu es à court de feedback structuré et douloureux. Construis les canaux pour ça, et tu apprendras plus en deux semaines qu’avec 20 captures d’écran supplémentaires de tableaux de bord de détecteurs.

Réponse courte : des captures d’écran de détecteurs + des auto‑évaluations par l’IA ne sont pas de “vrais retours utilisateurs”, ce sont des tests de labo. Tu es à moitié sur la bonne voie, mais tu t’adresses au mauvais public.

Quelques réflexions qui ne font pas que répéter ce que @mikeappsreviewer et @kakeru ont déjà dit :

-

Arrête de demander si ça “marche” et commence à demander pour qui ça marche

En ce moment tu cherches un peu une réponse universelle : “Est‑ce que mon humanizer d’IA est bon ?” C’est flou. En pratique il y a des cas d’usage très différents :

- Étudiants qui essaient de ne pas se faire détecter

- Rédacteurs qui veulent rendre leurs brouillons moins robotiques

- Non‑natifs qui veulent paraître plus naturels par email

- Marketeurs qui veulent garder la voix de marque

Ton problème de feedback vient peut‑être de là : tu laisses entrer tout le monde et tu n’écoutes aucun groupe précis. Choisis un ou deux segments et optimise tes boucles de retour autour d’eux.

-

Propose des presets assumés puis juge‑les selon ceux qui sont abusés

Au lieu de modes génériques comme “académique simple” ou “décontracté”, ancre‑les dans la vraie vie :

- “Polissage de dissertation universitaire”

- “Post LinkedIn de thought leadership”

- “Cold email à un manager”

- “Réparation d’intro de blog”

Ensuite :

- Suis quel preset est le plus utilisé

- Suis celui avec le plus de “tout copier” sans retouches

- Suis celui que les utilisateurs abandonnent en cours de route

Si “Polissage de dissertation universitaire” est très utilisé mais que les gens partent après un seul essai, tu as des données d’échec spécifiques et actionnables. C’est mieux qu’une capture d’écran de détecteur de plus.

-

Intègre une comparaison “Ma voix vs Voix humanisée”

Là je suis un peu moins aligné avec la focalisation extrême sur les détecteurs des autres : à long terme, les gens se soucient plus de la voix que du 0 % IA. Si le texte n’a plus l’air de venir d’eux, ils lâcheront ton outil même s’il est “indétectable”.

Laisse les utilisateurs :

- Coller le texte original

- Obtenir le résultat humanisé

- Voir un petit comparatif type diff :

- “Formalité : +20 %”

- “Tonalité personnelle : -30 %”

- “Longueur des phrases : +15 %”

Puis demande littéralement :

“Est‑ce que ça ressemble encore à ta façon de t’exprimer ?” [Oui / Moyen / Non]

Cette simple question te donnera un signal plus honnête qu’un “Note 1–5 étoiles”.

-

Tu as besoin d’incitations négatives, pas seulement de carottes

Tout le monde parle de cartes cadeaux, d’avantages bêta, etc. Le problème : les gens vont te dire ce que tu veux entendre pour garder les avantages.

Essaie plutôt :

- “Si tu nous envoies 3 résultats vraiment mauvais (captures ou copier‑coller), on t’offre X crédits en plus.”

- Tu ne récompenses pas “utiliser beaucoup l’outil”, tu récompenses “trouver où il échoue”.

Ça garde le focus sur tes points faibles, plutôt que sur des commentaires vagues “ouais c’est bien, merci”.

-

Crée un “Hall of Shame” en interne

Tu sais déjà que l’outil peut bien performer dans des conditions idéales. Ce que tu n’as pas, c’est un tas soigneusement sélectionné de :

- Pires sorties

- Phrases les plus gênantes

- Cas où le sens a été changé

- Cas où il fait parler l’utilisateur comme un blogueur IA générique

Une fois par semaine, prends :

- Les 50 sessions avec le plus de régénérations rapides

- Les 50 avec la fermeture la plus rapide après la sortie

Inspecte manuellement 10–20 d’entre elles et tague pourquoi c’était nul. C’est ce pattern qui va te faire progresser.

-

Impose de la friction à un endroit du funnel

Tu optimises probablement pour “sans login, ultra rapide, friction minimale”. Super pour le trafic, mauvais pour le feedback.

Envisage un “bac à sable feedback Pro” séparé :

- Email ou inscription minimale obligatoire

- Limites plus élevées ou modes supplémentaires

- En échange, les utilisateurs :

- Cochent 2 cases par sortie : “Naturel / Robotique” et “Dans le sujet / Hors sujet”

- Optionnellement ajoutent un contexte du type “J’ai utilisé ça pour [école / travail / réseaux sociaux]”

Les gens qui prennent 20 secondes pour s’inscrire sont beaucoup plus susceptibles de donner de vrais retours que les simples visiteurs de passage.

-

Intègre les attentes directement dans l’UI

Légère divergence avec l’hypothèse implicite que tu portes peut‑être : “Si c’est assez bon, l’utilisateur doit pouvoir cliquer sur copier et basta.” Ce n’est pas comme ça que les vrais gens utilisent ce genre d’outils.

Ajoute littéralement un texte comme :

“Cet outil te fait avancer à 70–90 %. Tu dois relire rapidement avant d’envoyer.”

Puis demande directement :

- “As‑tu encore dû beaucoup modifier ce texte ?” [Un peu / Beaucoup / J’ai quasiment tout réécrit]

C’est un feedback honnête qui ne demande pas un long sondage.

- “As‑tu encore dû beaucoup modifier ce texte ?” [Un peu / Beaucoup / J’ai quasiment tout réécrit]

-

Utilise la comparaison avec les concurrents sans être cringe

Comme les gens testent évidemment aussi des outils comme le humanizer de Grammarly, Ahrefs, Undetectable, etc., tu peux exploiter ça au lieu de faire comme s’ils n’existaient pas.

Ajoute une petite case à cocher :

- “As‑tu essayé des outils similaires (comme les humanizers IA de Grammarly ou Ahrefs) ?

- Oui et celui‑ci est meilleur

- Oui et celui‑ci est pire

- À peu près pareil

- Je n’ai pas essayé d’autres outils”

Pas de dénigrement de marque, pas de “on est les meilleurs”. Juste des données.

Utilise‑les pour comprendre ton positionnement, pas seulement la qualité. - “As‑tu essayé des outils similaires (comme les humanizers IA de Grammarly ou Ahrefs) ?

-

Arrête de supposer que réussir les détecteurs = succès produit

D’après ce que @mikeappsreviewer a montré, ton Clever AI Humanizer est déjà solide face aux détecteurs publics. Tant mieux. Mais demande‑toi :

- “Si tous les détecteurs disparaissaient demain, est‑ce que mon outil vaudrait encore la peine d’être utilisé ?”

Si la réponse honnête est “pas vraiment”, alors ta roadmap doit pencher vers :

- Personnalisation

- Contrôle du ton

- Sécurité (pas d’hallucinations, pas d’affirmations fausses)

- Préservation de l’intention d’origine

C’est ce qui restera quand la course aux détecteurs se calmera.

-

Positionne explicitement Clever AI Humanizer comme un outil de collaboration

Tu obtiendras de bien meilleurs retours si tu arrêtes de le présenter comme une cape d’invisibilité.

Exemple dans ton UI :

“Rédigé par IA, affiné par Clever AI Humanizer, finalisé par toi.”

Ça amène les utilisateurs à se demander :

- “En quoi est‑ce que ça m’a aidé ?”

- “Où est‑ce que ça m’a compliqué la vie ?”

Demande des retours dans ce cadre‑là :

- “Est‑ce que Clever AI Humanizer t’a fait gagner du temps sur ce texte ?” [Oui / Non]

- “Est‑ce qu’il a changé ton sens ?” [Oui / Non]

L’intersection “Pas de gain de temps” + “Sens modifié” est l’endroit où tu échoues le plus fort.

Si tu veux une action très concrète à mettre en place en une journée :

- Après chaque sortie, affiche 3 boutons :

- “J’enverrais ça tel quel”

- “Je l’utiliserais mais en le corrigeant”

- “Ce n’est pas utilisable”

- S’ils choisissent le dernier, pose une seule question de suivi :

- “Trop robotique / Hors sujet / Mauvais ton / Anglais approximatif / Autre”

Ce petit flow, à grande échelle, t’en dira plus sur la performance réelle de Clever AI Humanizer dans le monde réel qu’un mois de tests de détecteurs supplémentaires ou de questions à d’autres LLMs pour savoir s’ils sont “trompés”.

Analyse rapide d’un autre angle, puisque d’autres ont déjà creusé l’UX et les tests :

1. Considérer les “vrais retours” comme des données, pas des opinions

Au lieu de multiplier les expériences avec des détecteurs, branche des métriques solides autour de Clever AI Humanizer :

Chiffres principaux à suivre :

- Taux de complétion : texte collé → humaniser → copier.

- Taux de régénération par entrée : beaucoup de régénérations = insatisfaction.

- Temps avant copie : si les gens copient en 2–5 secondes, ils ne lisent pas, ils font de l’exploitation de sortie.

- Intention d’édition : clic sur “Copier avec mise en forme” vs “Copier en texte brut” vs “Télécharger”. Des schémas différents correspondent généralement à des cas d’usage différents.

Cela te donne un retour silencieux sur chaque session, pas seulement sur la poignée de personnes prêtes à t’écrire des pavés.

2. Segmentation légère par cohorte

D’autres ont proposé un ciblage par persona. Je le rendrais ultra simple :

À la première utilisation, un sélecteur en 1 clic au-dessus de la zone de texte :

- “Utilisation pour : École / Travail / Réseaux sociaux / Autre”

Pas de connexion, pas de friction. Juste un tag de cohorte anonyme.

Tu peux alors voir :

- École : taux de régénération et d’abandon les plus élevés

- Travail : temps passé sur la page le plus long mais fort taux de copie

- Social : copie rapide, longueur faible, peut-être pas la peine d’optimiser

Tu ne devines plus quel public tu es en train de rater.

3. A/B test “humanisation agressive vs conservatrice”

Actuellement Clever AI Humanizer semble optimisé pour l’évasion des détecteurs plus la lisibilité. C’est correct, mais des utilisateurs différents veulent des niveaux d’édition différents.

Lance un test discret :

- Version A : changements minimaux, structure préservée, paraphrase légère

- Version B : réécriture plus lourde, plus de variation, rythme davantage modifié

Puis compare :

- Quelle version génère le plus de comportements “copier et partir”

- Quelle version déclenche le plus de “Relancer”

Pas de sondage, pas de supplication pour des retours. Le comportement donne la réponse.

4. Pour / contre comme réalité produit

Par rapport à ce que @kakeru et @andarilhonoturno ont décrit, je pense que ton outil est déjà dans la catégorie “mieux que la moyenne”, mais ça aide de nommer les choses clairement :

Avantages de Clever AI Humanizer

- Bonne performance face aux détecteurs d’IA courants quand on teste sur du contenu réaliste.

- Sortie généralement propre et grammaticale, sans l’astuce forcée des “fautes volontaires” que certains outils utilisent.

- Plusieurs styles (académique simple, décontracté, etc.) qui correspondent assez bien à des situations d’écriture réelles.

- Rédacteur IA intégré capable de générer et humaniser en un seul passage, ce qui réduit les empreintes évidentes de LLM.

- Onboarding gratuit et léger, ce qui est idéal pour l’adoption initiale et alimente beaucoup de données de test.

Inconvénients de Clever AI Humanizer

- Contrôle du nombre de mots approximatif, ce qui est un vrai problème pour les devoirs et briefs stricts.

- Réécrit parfois trop fortement, introduisant une dérive de contenu que les utilisateurs ne verront pas toujours.

- Même avec 0 % d’IA aux tests, certains textes “sonnent” encore comme générés par machine dans la structure et le rythme.

- Une proposition de valeur centrée sur les détecteurs te met dans un jeu permanent du chat et de la souris et peut mal vieillir.

- Peu de personnalisation explicite de la voix, donc les utilisateurs fréquents peuvent avoir l’impression que leurs textes finissent par se ressembler.

5. Arrêter le sur‑ajustement aux détecteurs, sur‑ajuster aux utilisateurs récurrents

C’est là que je diverge un peu de la focalisation sur les détecteurs qu’on voit dans les tests de @mikeappsreviewer. Les captures d’écran de détecteurs sont un marketing utile, mais un objectif produit fragile.

Signal plus durable :

- Combien d’utilisateurs reviennent sous 7 jours

- Parmi les revenants, combien voient la taille de leurs sessions augmenter en nombre de mots dans le temps (signal de confiance)

- À quelle fréquence le même navigateur / IP utilise l’outil dans des contextes différents (école + travail, etc.)

Les vrais utilisateurs ne restent pas parce qu’un détecteur a dit “0 % IA”. Ils restent parce que :

- Ça leur a fait gagner du temps.

- Ça ne les a pas mis dans l’embarras.

- Ça n’a pas trahi ce qu’ils voulaient dire.

Optimise d’abord pour le comportement récurrent, ensuite pour les scores de détecteurs.

6. Construire un “pattern de confiance” plutôt qu’un “pattern de camouflage”

Tu ne devrais pas essayer de battre tous les détecteurs futurs. Tu devrais essayer d’être l’outil qui :

- Ne casse pas le sens.

- Permet d’ajuster le ton.

- Explique clairement ses limites.

Un ajout d’UI subtil mais payant :

- Après la sortie, afficher un court résumé honnête du type :

- “Conservation du sens : élevée”

- “Changement de ton : modéré”

- “Changement de structure de phrase : élevé”

Les gens commencent à te faire confiance parce que tu montres ton fonctionnement. Cette confiance t’apporte indirectement de meilleurs retours que n’importe quel sondage.

7. Obtenir du feedback qualitatif sans harceler

Inspire‑toi de déclencheurs basés sur le comportement :

-

Si l’utilisateur lance 3+ régénérations sur la même entrée :

- Affiche un petit prompt en ligne :

- “Vous n’obtenez pas ce qu’il vous faut ? Dites‑le en 5 mots.” [petit champ texte]

Ça donne des commentaires brutalement honnêtes du genre “trop robotique”, “a changé mon propos”, “trop verbeux”.

- “Vous n’obtenez pas ce qu’il vous faut ? Dites‑le en 5 mots.” [petit champ texte]

- Affiche un petit prompt en ligne :

-

Si l’utilisateur passe >40 secondes à éditer du texte dans ta zone avant humanisation :

- Demande : “Vous corrigez un texte IA ou vous polissez votre propre écriture ?”

Ça t’aide à comprendre si Clever AI Humanizer est perçu comme “correcteur d’IA” ou “éditeur”, ce qui compte pour la roadmap.

- Demande : “Vous corrigez un texte IA ou vous polissez votre propre écriture ?”

Pas de gros modales, pas de “mettez‑nous 5 étoiles”, juste de petites sollicitations contextuelles.

8. Positionner les concurrents dans ton modèle mental

Tu as déjà de bonnes comparaisons grâce à des gens comme @kakeru et la revue plus axée détecteurs de @mikeappsreviewer. Utilise‑les comme benchmarks, pas comme boussoles.

Considère‑les comme :

- “Voilà ce qui se passe quand on pousse l’évasion des détecteurs et qu’on ignore la voix.”

- “Voilà ce qui se passe quand on fait une paraphrase légère, sûre mais détectable.”

L’atout de Clever AI Humanizer est d’essayer d’équilibrer lisibilité et détection. Ton prochain avantage devrait être la personnalisation et le contrôle, pas seulement des pourcentages plus bas sur un énième détecteur public.

Si tu veux une chose concrète à livrer cette semaine qui améliorera le produit tout en te donnant un signal réel :

- Ajoute deux interrupteurs avant l’humanisation :

- “Préserver au maximum la structure”

- “Changer la structure pour plus de variation humaine”

Puis journalise quelle combinaison d’options est corrélée à :

- Des taux de copie plus élevés

- Moins de régénérations

- Plus de sessions de retour

Tu sauras très vite quel type “d’humanisation” tes vrais utilisateurs veulent réellement, au lieu de deviner à partir de graphiques de détecteurs.